Google Mnie nie kocha – i to tak od stycznia 2020 roku 😉 Tymi słowami niemalże każda seowczyni i niemalże każdy seowiec powita „czerwony” poranek, gdy w monitoringu widzi spadki pozycji dla słów kluczowych, które pozycjonuje u klienta. W tym momencie włącza się tryb „bez kawy” i zaczyna się proces szukania informacji po forach oraz analizowania przyczyn spadku a tym samym chęć jak najszybszego rozwiązania problemu i powrotu na wysokie pozycje.

Tylko problem polega na tym, że SEO działa wolno a spadki mogą być nagłe i pomimo szczerych chęci „szybko” nie da się wykonać.

Core oraz Spam Link Updates – mały rys historyczny

Zacznijmy od tego, że w wytycznych Google dla Webmasterów nie ma słowa o pozycjonowaniu. Google stoi na stanowisku, że treści oraz strona powinna być przyjazna dla użytkownika, treści angażujące i merytoryczne, budujące zaufanie. Google niczego nie zabrania tylko dostarcza wskazówki.

Co powinni właściciele serwisów wiedzieć o aktualizacjach typu „core” jest opisane na stronie Google: https://developers.google.com/search/blog/2019/08/core-updates

W 2020 i 2021 praktycznie większość aktualizacji dotyczyła właśnie „core” stąd warto, moim zdaniem, śledzić Twittera: https://twitter.com/googlesearchc/status/1460970568128385031

Ważne daty tego typu aktualizacji:

- 17/18 listopad 2021 – core update – https://searchengineland.com/google-november-2021-core-update-rolling-out-today-376124

- 26 lipiec 2021 – link spam update – https://www.searchenginejournal.com/google-link-spam-update/414623/

- 1 lipiec 2021 – core update – https://www.searchenginejournal.com/google-july-2021-core-update-begins-rolling-out/412169/

- 23 oraz 28 czerwiec 2021 – link spam update – https://www.searchenginejournal.com/google-spam-update-part-2/412023/ oraz https://www.searchenginejournal.com/google-rolls-out-new-spam-update/411526/

- 2-4 czerwca 2021 – core update – https://www.searchenginejournal.com/google-broad-core-algorithm-update-rolling-out-june-2/409211/

- 4 grudnia 2020 – core update – https://www.searchenginejournal.com/google-december-2020-core-update/389543/

- 4 maja 2020 – https://www.searchenginejournal.com/google-confirms-may-2020-core-algorithm-update-rolling-out-today/365974/

- 12/13 stycznia 2020 – https://www.searchenginejournal.com/google-january-2020-core-update-is-rolling-out-imminently/343271/

Aktualizacje algorytmu 2020 i 2021 – Core Update – na co zwrócić uwagę?

Najprościej zacząć od analizy widoczności oraz sprawdzenia korelacji pomiędzy datami aktualizacji oraz spadkami widoczności. Wzrosty widoczności też mile widziane, ale jak rośnie to jest radość a my będziemy rozmawiać o spadkach.

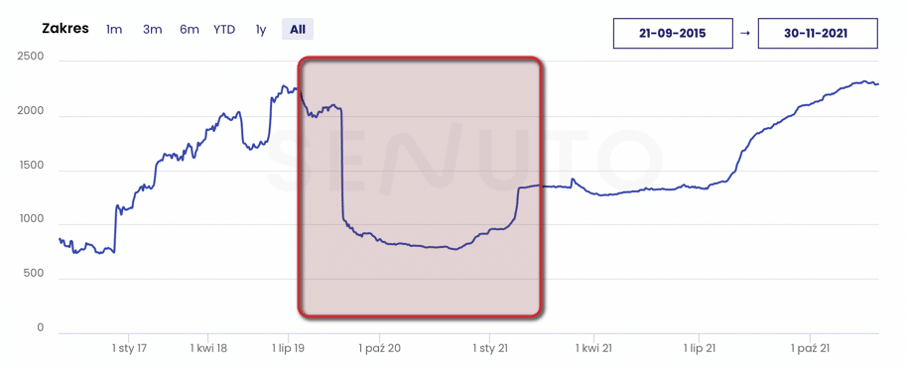

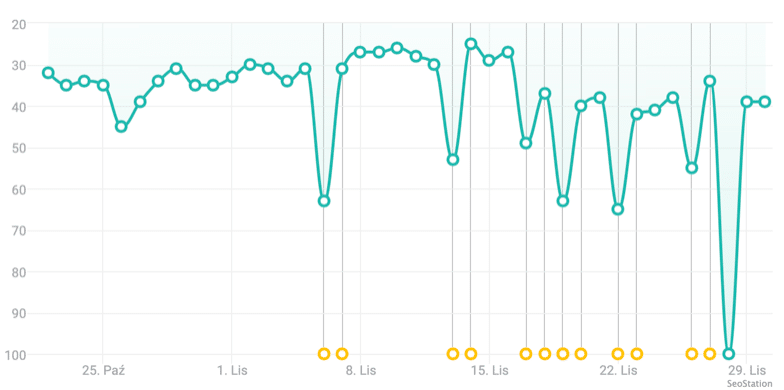

Przykład 1:

Na rysunku powyżej (narzędzie: senuto.com) serwis podlega spadkowi 4 maja 2020 a powrót nastąpił 4 grudnia 2020.

W tym konkretnym przypadku założyliśmy po krótkiej analizie, że:

- treści nie są problemem

- linkbuilding – wykluczyliśmy to po analizie – aczkolwiek mógłbym się do paru kwestii przyczepić

- analizujemy aspekty techniczne związane z tym co widać w GSC oraz architekturę informacji a także linkowanie wewnętrzne

Zdiagnozowane problemy:

- nagromadzenie starych podstron, które generowały treści osierocone a te z kolei trafiały do sandboxa

- niewłaściwie wykonane przekierowania w tym przekierowania w menu nawigacyjnym

- usunięto linki wychodzące

- błędnie wykonane linki wewnętrzne w tym wiele podstron z tylko jednym linkiem wewnętrznym dochodzącym do danej podstrony

- błędnie zaimplementowany canonical – niektóre wskazywały podstrony z założonym „noindex”

- mixed content

Naprawa tych wszystkich rzeczy nie przyniosła spodziewanego powrotu do zdrowia – trzeba było czekać aż do nowej aktualizacji, aby część widoczności powróciła. Takim „magic baguette” jest crawl budget oraz dogłębna analiza danych z GSC plus audyt techniczny narzędziami seo.

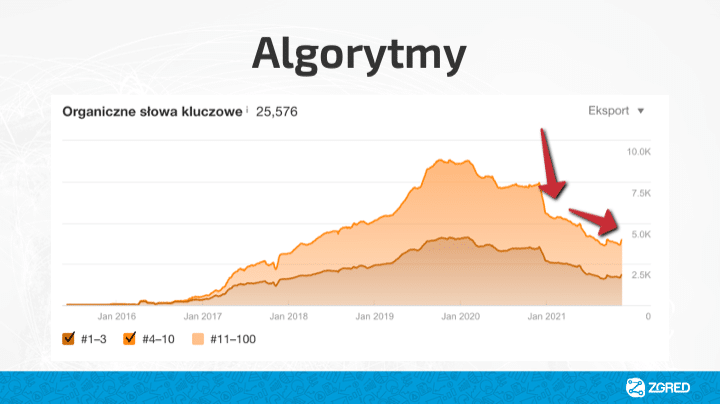

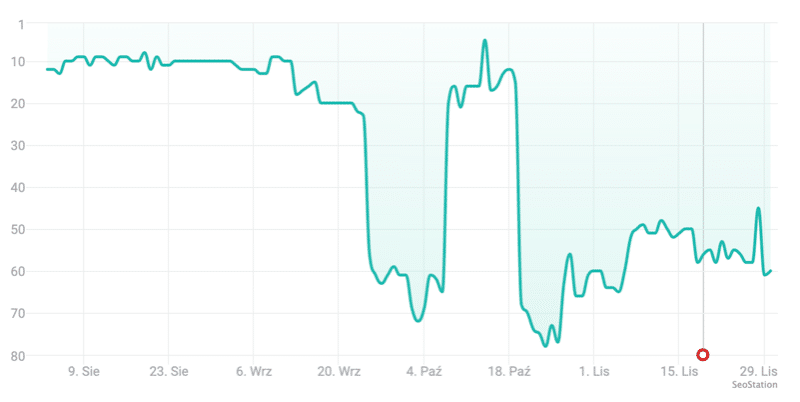

Przykład 2:

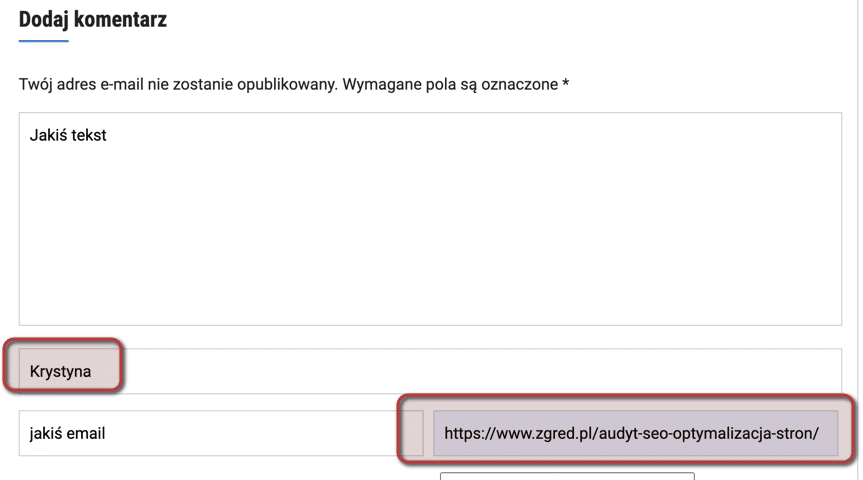

Na rysunku powyżej (narzędzie: ahrefs.com) pokazany jest mocny spadek 4 grudnia 2020 – tego dnia miała miejsce aktualizacja w Google. I jak widać utrata widoczności mocno postępuje.

W takim przypadku analizujemy:

- linkowanie wewnętrzne a właściwie jego brak oraz niewłaściwe wykonanie

- nagromadzenie „thin content” w serwisie

- kanibalizacje na słowa kluczowe

- możliwe przebudowy serwisu

- niewłaściwa architektura serwisu co skutkuje powstawaniem osieroconych treści

Ten serwis ma bardzo dużo za uszami i pracy na wiele tygodni.

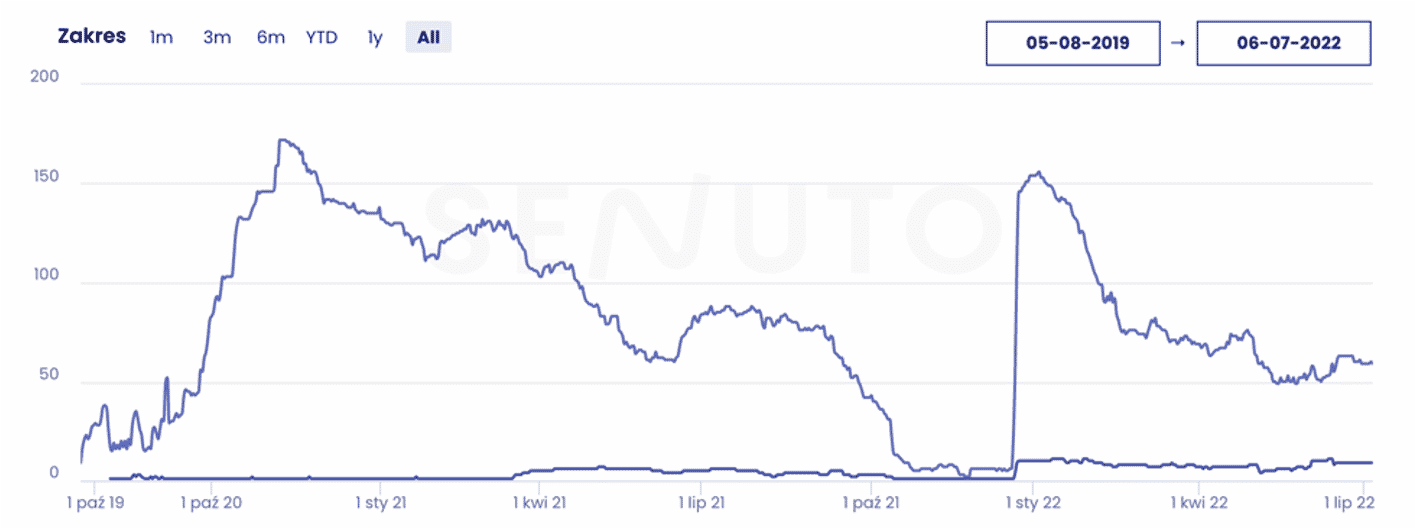

Przykład 3: (dodany 27.03.2022)

Klienta martwił sukcesywny powolny spadek widoczności skorelowany z powolnym spadkiem pozycji dla poszczególnych fraz kluczowych, w tym fraz typu money keyword.

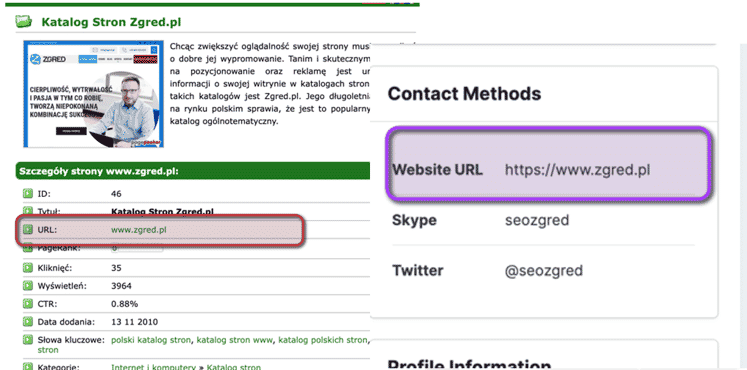

Weryfikacja profilu linków pod kątem algorytmu (2021) typu SPAM CORE UPDATE wskazuje jednoznacznie na odnośniki na forach (tak – dużo for z naciskiem na fchuj dużo):

- gdzie w profilu użytkownika jest podstrona serwisu – w większości przypadków są to gołe URL (naked url) ale zdarzały się też frazy typu money keyword

- w stopce na forach – czyli w podpisie

- w treści sporadycznie także typu money keywords

Wiele z for było zapuszczonych, bez certyfikatu SSL, zaspamowanych linkami. Odnośniki wykonane w latach 2019-2021. Rekomendacją jest usunięcie jak największej liczby takich linków.

Drugi problem z odnośnikami to komentarze wykonane w niestandardowy.

W tym przypadku problemem jest podstawienie pod imię adresu URL, który dowolną podstroną w serwisie. Pomimo parametru UCG (nofollow) rekomendacja to używanie brand name (nazwy firmy lub nazwy domeny) i wstawianie zawsze adresu do strony głównej.

Przykład 4: (dodany 27.03.2022):

Serwis został niemalże całkowicie „wycięty”.

Niestety nie mogę wkleić za wiele ale wystąpiły dwa głównej problemy:

- zaplecze starego typu z lat „ubiegłego wieku” – czyli bardzo krótkie artykuły z anchorami

- program partnerski, który więcej zaszkodził niż pomógł

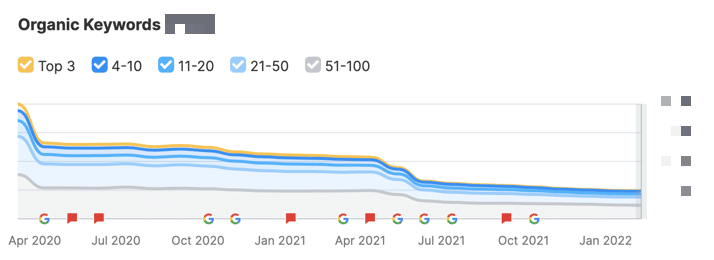

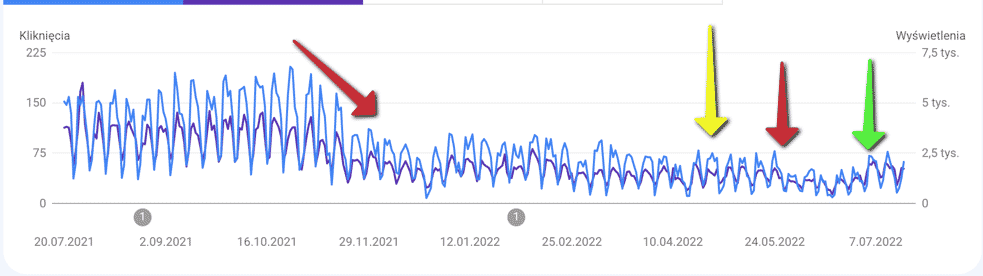

Przykład 5: (dodany 21.07.2022)

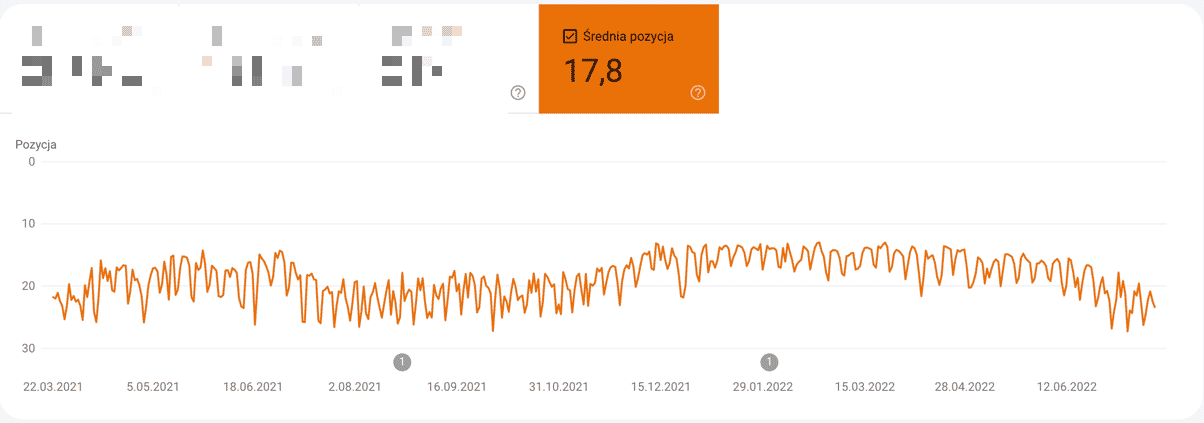

Serwis prawniczy stracił widoczność oraz ruch organiczny zaraz po aktualizacji algorytmu w listopadzie 2021 – poniżej widok utraty ruchu organicznego z GSC:

Pierwszy spadek listopad 2021, poprawka w 25 maja 2022. Żółta strzałka oznacza początek naszej współpracy. Zielona – odbicie w ruchu organicznym i powrót praktycznie 80% fraz na pozycje. Teraz czekamy na powrót długiego ogona oraz reindeksację całości.

Główne problemy:

- usunęliśmy praktycznie 90% odnośników, które były wykonane za pomocą NAP’ów ale do podstron a nie strony głównej

- katalogi stron to było raczej wewnętrzne zaplecze firmy

Przykład 6: (dodany 21.07.2022)

Branża suplementów diety – kilka przypadków analizowaliśmy i mamy następujące wnioski pod kątem potencjalnych problemów z linkami:

- stare zaplecza wykonane na „jedno kopyto” czyli wyglądające tak samo i zrobione tą samą techniką

- nagromadzenie money keywords oraz słów generycznych w linkowaniu zewnętrznym idące nie w kilka/naście sztuk ale w setki

- przekierowywanie domen dopiero co pozyskanych (expirki) bez weryfikacji na ile są pożyteczne zamiast skupić się na odzyskaniu ich potencjału SEO (stawiając content) a dopiero po kilku miesiącach 301 na serwis pozycjonowany

- widgety na serwisach zewnętrznych z linkami dofollow dające miliony backlinków

- powielanie menu na zapleczach z linkami dofollow do serwisu pozycjonowanego (czyli ktoś po prostu skopiował całe drzewo menu i wkleił na innym portalu – nie raz, nie dwa ale kilkanaście razy)

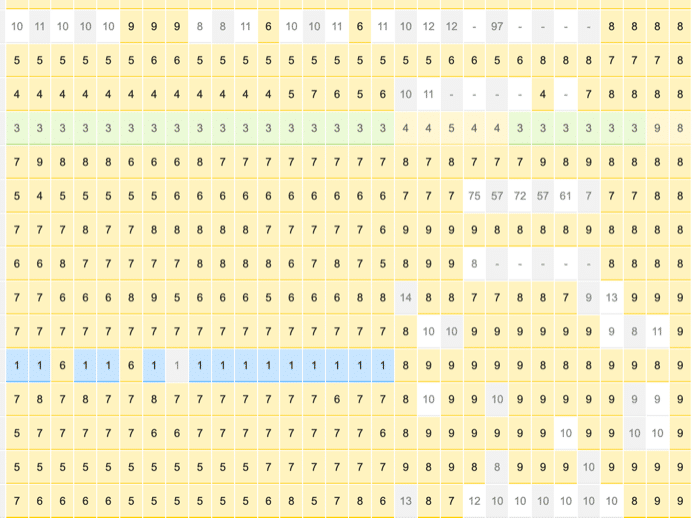

Przykład 7: dodany 23.07.2022

Klient miał wypracowane doskonałe pozycje, treść zoptymalizowana na tiptop. Z racji niszowego tematu trudno zaobserwować zmiany w ruchu. Nie mniej monitoring pozycji wskazuje na problemu z linkami (powolny spadek ale tylko na niektóre frazy) oraz spory spadek na średniej w GSC

Co zostało, moim zdaniem, spartolone:

- linkbuilding typu katalogi (nawet nie są to seo katalogi) do podstrony, na którą chciano podbić

- zaplecza gdzie najdłuższy tekst nie przekracza 1000 zzs w połączeniu z brakiem ssl oraz money keywords (naked URL w tym przypadku nie daje żadnej korzyści)

- zaplecza nie mają żadnej widoczności (jeden miał – sorry – załączam wykres)

- część serwisów nie ma SSL (w połączeniu ze sposobem wykonania linków to podstawa do spam score, brak ssl nie szkodzi)

- linkbuidling na blogspotach (testowałem na zgredzie możecie zajrzeć w profil – to nie pomaga)

- profile na forach (tych zjechanych tak, że trawa na autostradzie nie urośnie)

Innymi słowy – do natychmiastowego wycięcia wszystkie linki. Disavow nawet nie pomoże – nie ma szans.

Dlaczego kanibalizacja słów kluczowych jest ważna w kontekście Core Update?

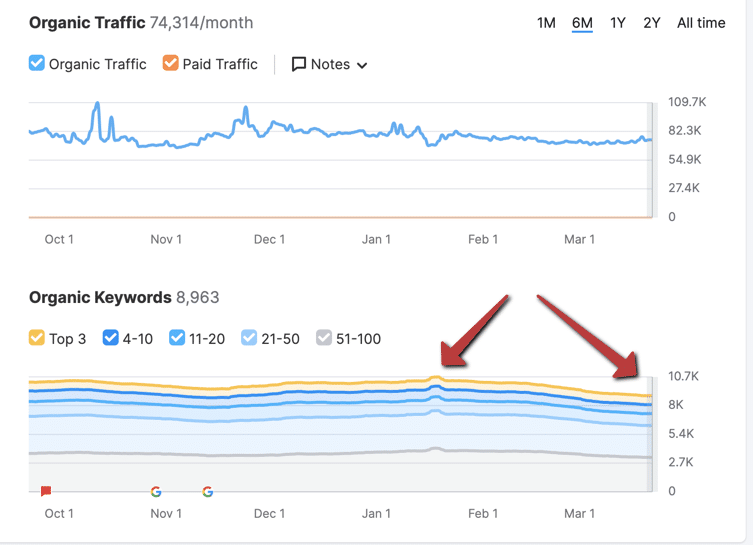

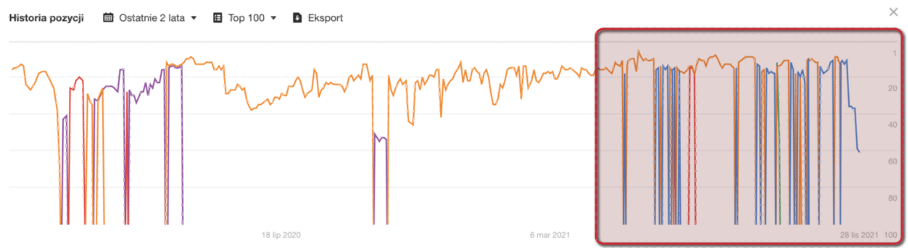

Ano dlatego. Rysunek poniżej pokazuje efekt pojawienia się kanibalizacji na słowa kluczowe już 4 czerwca 2021

Tutaj bardzo ważna rzecz – do 4 czerwca 2021 kanibalizacje były bardzo sporadyczne, można rzec nawet iż nie przeszkadzały. Od tego dnia miało to już ogromne znaczenie jednak wychwycenie tego było dość trudne. Dopiero listopadowy core update pokazał jak bardzo kanibalizacja przeszkadzała. W tym przypadku aż kilka stron jest zoptymalizowanych pod te konkretna frazę – więc do wykonania jest deoptymalizacja połączona z przebudową podstron i treści.

Reszta rzeczy schodzi na dalszy plan jako mało priorytetowe zagadnienia.

Przykład drugiego serwisu, obserwowanego przez Nas, gdzie kanibalizacja pojawiła się i mocno pokiereszowała serwis:

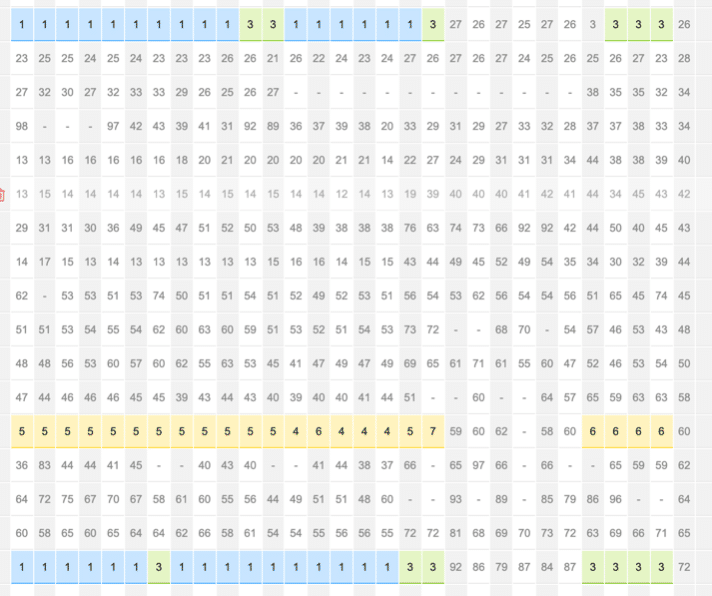

W sumie wklejam dwa zrzuty z webpozycja.pl – jak widać aktualizacja listopadowa bardzo mocno odcisnęła się na serwisie. Wiele podstron zostało wyrzuconych niemalże z top100, część wróciła na te same lub lekko niższe pozycje.

Co się wydarzyło:

- Google z niewiadomych przyczyn zaczął lepiej traktować podstrony paginacji a nie stronę pierwszą (uwaga: tekst jest tylko na pierwszej stronie paginacji, canonical prawidłowy, self canonical na każdej podstronie – wszystko zgodnie z wytycznymi)

- Kanibalizacja pojawiła się na podstronach, na których nie było słowa kluczowego w treści – ale jest w kodzie ze względu na menu. To zjawisko, że jakaś podstrona kanibalizuje na frazę, która jest w kodzie, ale nie mam jej w treści obserwuję od maja 2020 roku

Jak widać pozycje same wróciły, jak skończyło się wdrożenie aktualizacji algorytmu, niemniej jednak na miejscu właściciela byłbym lekko zdenerwowany.

I trzeci przykład – serwis od 2 lat nie ruszany palcem, stoi jak stał. Rankował. Wszystko dopięte na tip top. I kupa….

Spójrzcie na liczbę żółtych kropek – co chwila pojawia się kanibalizacja.

„Przegrzanie” linkami czyli aktualizacja algorytmu typu Link Spam Update

Od wielu lat Google nie nakłada kar za linkbuidling. Wartość linków jest zerowana (podobno) w locie i tym samym nie ma wpływu na serwis pozycjonowany, a jeśli już dotyczy to pojedynczych podstron.

W tym przypadku bez monitorowania słów kluczowych w jakimś narzędziu SEO trudno będzie o bieżącą weryfikację. Chyba, że jest to fraza sprzedażowa

Google stoi na stanowisku, że analizuje cały serwis, ale również pojedyncze podstrony (hmm…. Był kiedyś taki algorytm o nazwie Phantom, który potrafił karać pojedyncze podstrony).

Niemniej jednak czy można przegrzać serwis linkami? Tak, a widać to m.in. po:

- Liczba linków do podstrony lub dosłownie kilku podstron serwisu jest większa niż do strony głównej. W tym przypadku trzeba po prostu usuwać linki do podstron. Efektem jest spadek wszystkich fraz powiązanych ze stroną główną oraz podstronami

- Niewłaściwy rozkład anchorów lub tez nietrafiony ich dobór – najczęściej linkujemy na money keywords w połączeniu z ogromną liczba adresów URL (po co?)

- Linki z syfiastych podstron – nie będę określał toksyczności czy pokazywał „syfu” niemniej jednak jeśli obsuwa się grupa fraz powiązanych tylko z jedną podstroną to trzeba działać. Pomaga zmiana strategii: lepszej jakości odnośniki do podstrony połączone ze zmianą anchorów historycznie pozyskanych. Ale jeśli spojrzeć na obrazek poniżej to nawet dołożenie contentu do serwisu, z którego linkujemy, nie pomogła. Po pewnym czasie świeży content przestaje pracować bo cała witryna jest po prostu do dupy.

Dodatkowo dla tak spadających fraz warto wstecznie zweryfikować miejscówki pod kątem utraty certyfikatu SSL. Zdarzyło się, że usuwaliśmy linki z tych serwisów, które miały problemy z certyfikatem.

Poza zmianami anchorów na frazy kilkuwyrazowe, pytania, części zdania, kliknij/wejdź/zobacz warto tez wstecznie pousuwać odnośniki właśnie ze stron problematycznych.

Aktualizacja algorytmu Google – gdzie znaleźć spis?

Spis aktualizacji algorytmów Google możemy znaleźć pod adresem:

- https://www.searchenginejournal.com/google-algorithm-history/

- https://moz.com/google-algorithm-change

NIektóre narzędzia np ahrefs czy semrush na wykresie wprowadzają informacje odnośnie aktualizacji algorytmów.

Nie zawsze wygrywamy

Szczerze? Nie wszystkie analizy czy próby poprawienia serwisu kończą się sukcesem. Mam kilka rozgrzebanych rzeczy, dla których powyższe nie sprawdza się. Są to portale contentowe (stricte) i wstępnie podejrzewam, iż problemem jest sposób przygotowywania treści (muszę zagłębić się w webinar Blueranku o tutaj: https://www.youtube.com/watch?v=haiECclbmVI – może tam znajdę odpowiedź).

Patrząc tylko na powyższe zauważcie jak wielką wagę przykładam w analizach do aspektów technicznych, crawl budget, linków wewnętrznych oraz kanibalizacji.

Jeśli ktoś chce się podzielić swoimi uwagami w temacie tych aktualizacji – zapraszam do dyskusji

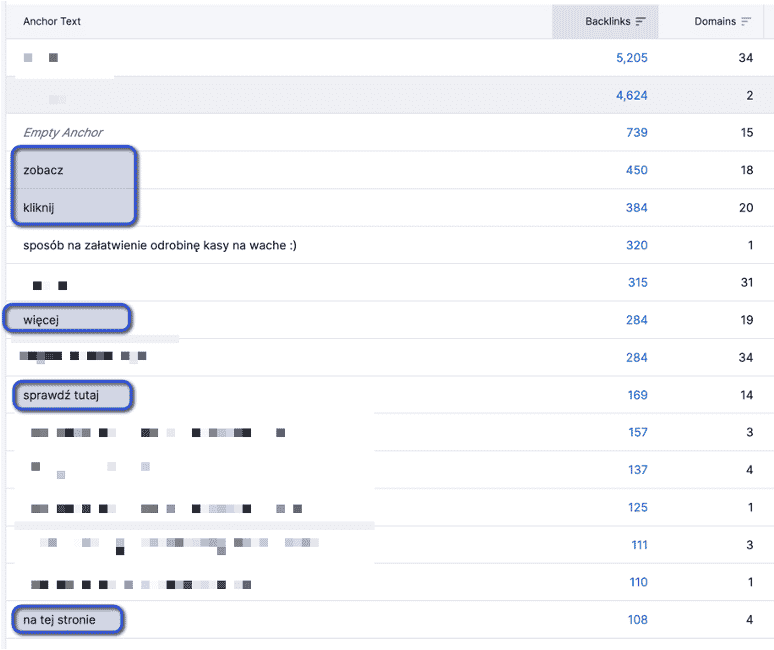

„Niewłaściwy rozkład anchorów lub tez nietrafiony ich dobór – najczęściej linkujemy na money keywords w połączeniu z ogromną liczba adresów URL (po co?)”

Jakiś przykład?

No nie moge pokazać dokładnie ale może ten obrazek podpowie, że to też działa 😀

Nie wiem czy dobrze rozumiem. Czyli nie powinno się mieć linków typu „sprawdź tutaj”, „zobacz” itd Tylko należy je zastąpić innym tekstem? Co w przypadku serwisów, gdzie to niemożliwe albo trudne?

Odwrotnie. Warto skorzystać z takich kotwic przy linkowaniu.

Paweł rozwiniesz tą myśl? Ja też żyję w przeświadczeniu że lepiej „dokładniej” na słowa dawać anchory, a mniej stosować – dalej, sprawdź… czy chodzi o to, że takie „ogólne cta” powinny być kotwicami do sekcji danej podstrony, a linki wewnętrzne już słowami na których nam zależy?

Anchory w linkowaniu WEWNĘTRZNYM – tak. Natomiast w ZEWNĘTRZNYM trzeba różnicować. Jeśli wszystko robisz na money keywords to, moim zdaniem, jest to zła strategia.

Co to są strony z treściami osieroconymi?

Osierocone strony to takie, do których prowadzi jeden lub zero linków wewnętrznych. Na wykresach np. z narzędzia sitebulb podstrony takie są pokazane jako te, do których trzeba wykonać 10 lub więcej kliknięć aby się do nich dostać.

Co masz na myśli pisząc:

„Niewłaściwy rozkład anchorów lub tez nietrafiony ich dobór – najczęściej linkujemy na money keywords w połączeniu z ogromną liczba adresów URL (po co?)”

Chodzi o to że linkowanie jest tylko na money keywords lub url?

Tak. Kotwicami są money keywords i/lub URLe. Owszem to działa ale do pewnego momentu.

Trafiłem na ten wpis ponieważ mam właśnie taką sytuację. Dla bezpiecznego seo stosowałem w 90% URLe oraz 10% money keywords. Od roku widzę powolne spadki. Czy Twoim zdaniem zdobywanie nowych linków ze zróżnicowanymi anhorami typu „sprawdź tutaj”, „zobacz” itd pomoże w odwróceniu tej sytuacji?

To nie musi być wina/problem linków a mogą być problemy techniczne lub problem z treściami. CORE jest mocno szeroki więc bez adresu trudno mi o diagnozę. Jeśli od roku widzisz spadki to trzeba jednak przyjrzeć się stronie a nie linkom jako takim.

Wydaje się, że logiczna struktura strony www ma teraz rzeczywiście znacznie. Jak zawsze chodzi o pokazanie stron przyjaznych użytkownikowi google. Piszesz o „nagromadzenie „thin content” w serwisie”. Google mówi o “low-quality or shallow pages on your site” czy masz jeszcze jakieś wytyczne, obserwacje jak unikać tego rodzaju podstron?

A dasz rade uniknąć takich podstron? No nie. Oczywiście można zapobiegać ale uniknąć problemu nie da się. Po prostu co jakiś czas przeglądam serwisy i szukam.

Jeśli Google bierze pod uwagę kod strony i co się w nim znajduje, to czy w takim razie warto też uzupełniać meta description, który podobno nie jest brany pod uwagę?

Warto uzupełniać ale jak serwis ma tysiące produktów to nie ma sensu – nikt nie będzie klepać tysięcy meta, które za chwilę i tak znikną bo asortyment mocno rotuje. Lepiej wtedy zadbać o opisy produktów oraz opinie.

Ok, a czy jesteś zwolennikiem usunięcia podstron, które mimo zmiany treści – raz, że się nie chcą zaindeksować ( po zmianie contentu), jak i nie generują kliknięć w ciągu np. miesiąca?

Jestem zwolennikiem sprawdzenia czemu tak się dzieje i wyciagnięcia jak najwięcej się da. Tak więc nie usuwam podstron bo nic się nie dzieje tylko je optymalizuje i myślę, co zrobić aby przynosiły korzyści.

A opinie to masz na myśli na danej stronie sklepu? czy bardziej poza stroną sklepu?

W sklepie. Własne opinie to unikalny content 🙂

Jak sobie radzisz z updateami, które dotyczą strony tylko z danej branży. Np. widzisz, że ty i 4 z 6 Twoich konkurentów spada lub rośnie w tym samym czasie. Zastanawiam się jaki mamy wpływ na tego typu fluktuacje.

Analizujemy – czasem bardzo dokładnie. Nie dalej jak kilka dni temu zakończyliśmy analizy linkbuildingu i będziemy wdrażać zmiany, które zaobserwowaliśmy iż coś nie działało jak należy. Ja tez dużo testuję od grudnia 2021 i też mam obserwacje, które wdrażać będziemy „na klientach” – takie testy same z siebie. Na jeden z testów „namówiło” mnie wystąpienie Szymona i Macieja w związku z budową PBNów 🙂