Widoczność witryny internetowej w sieci to czynnik kluczowy dla rozwoju firmy. W przypadku, gdy strona nie będzie się prawidłowo wyświetlać, wówczas internauci nie będą mieli szansy trafić na nią w organicznych wynikach wyszukiwania. W pierwszej kolejności serwis musi zostać zaindeksowany. Każdego dnia roboty skanujące zawartość serwisu, przedzierają się przez gąszcz podstron. Ile z nich są w stanie zaindeksować?

Pojęcie Crawl Budget dla wielu osób brzmi zupełnie obco. Koniecznie zapoznaj się z poniższym tekstem, jeżeli interesuje Cię:

- czym jest Crawl Budget,

- w jaki sposób można go rozumieć,

- czy istnieją skuteczne sposoby jego optymalizacji

- jakie korzyści przyniesie zwiększenie ilości indeksowanych dziennie stron,

Stawiamy w nim na maksymalną przystępność prezentowanych treści tak, aby to enigmatyczne dotąd pojęcie stało się jasne, klarowne i zrozumiałe dla każdego administratora i użytkownika stron internetowych.

Crawl Budget – co to jest?

Crawl budżet to nic innego, jak budżet indeksowania witryny. W największym skrócie – chodzi o to, jak roboty Google indeksują stronę internetową. Crawl Budget może być pojmowany w dwojaki sposób. Jedna z interpretacji zakłada, iż jest to ilość czasu poświęcanego przez boty na indeksację. Można też rozpatrywać tę problematykę pod kątem liczby podstron, jakie w skali dnia uda się botom zaindeksować. Która z tych definicji bardziej do Ciebie przemawia?

Spora grupa specjalistów z obszaru technicznej optymalizacji serwisów internetowych skłania się coraz częściej ku temu, aby pojęcie Crawl Budget traktować właśnie w ujęciu czasu. Mając tak pojmowany wskaźnik, łatwiej jest wdrożyć zalecenia optymalizacyjne i zobaczyć ich efekty. Od ilości czasu, jaki boty spędzają na kolejnych podstronach, zależy więcej, niż może Ci się wydawać. Im dłuższy czas, tym mniej stron są w stanie zaindeksować.

Crawl Budget – czym jest?

Niemal w każdym aspekcie życia, czas to pieniądz. Współczesny świat dąży do jak największej optymalizacji wszelkich działań, tak by maksymalnie oszczędzać czas. Warto takie założenia optymalizacyjne wprowadzić w życie także w odniesieniu do witryny internetowej, a można sporo na tym zyskać.

Rozpatrując kwestię, jaką jest Crawl Budżet w ujęciu czasu, należy zwrócić szczególną uwagę na jedną kwestię, a mianowicie czas odpowiedzi poszczególnej strony. Im będzie on krótszy, tym więcej stron w ujęciu dziennym będzie mógł sprawdzić robot. Wbrew temu, co może się przynajmniej niektórym wydawać, nawet Google ma ograniczone zasoby, trzeba zatem zrobić wszystko, aby wykorzystać je, maksymalnie jak tylko się da, zwłaszcza że można z tego będzie czerpać realną korzyść.

Kolejną sprawą, o której trzeba pamiętać, jest fakt, że Crawl Budget w dużej mierze uzależniony jest od indywidualnego charakteru strony. Nieco inaczej będzie się on przedstawiał w przypadku wizytówki firmowej z niewielką ilością podstron, a zupełnie inaczej będzie wyglądał w przypadku serwisu, w którym na co dzień pojawia się wiele nowych newsów i każda ze stron powinna być na bieżąco indeksowana. Czy to oznacza, że pojęciem budżetu indeksowania witryny powinni na stałe zaprzyjaźnić się wyłącznie administratorzy dużych serwisów? Oczywiście, że nie! Nawet w przypadku mniejszych stron może dojść np. do duplikacji contentu czy istotnych błędów w strukturze, które przyczynią się do problemów z indeksacją.

Rękę na pulsie powinni zatem trzymać wszyscy administratorzy serwisów internetowych, niezależnie od ich wielkości. Szczególna czujność przyda się oczywiście tym stronom, na których każdego dnia pojawiają się nowe informacje, które powinny być na bieżąco indeksowane, by jak najszybciej móc wyświetlać się użytkownikom w naturalnych wynikach wyszukiwania.

Chcąc maksymalnie zoptymalizować Crawl Budget, należy ze szczególną troską przyjrzeć się jego parametrom składowym, wśród których wyróżnić można:

- crawl rate limit,

- crawl demand,

- crawl health.

Jeżeli brzmią one dla Ciebie bardzo tajemniczo i nie bardzo wiesz, co się za nimi kryje, to zapoznaj się z dalszą częścią artykułu, a sprawa powinna się nieco bardziej rozjaśnić.

Parametry Crawl Budget – co trzeba o nich wiedzieć?

Jak już zostało wspomniane w poprzednim akapicie, można wyróżnić trzy najważniejsze parametry mające ogromny wpływ na Crawl Budget.

Crawl rate limit

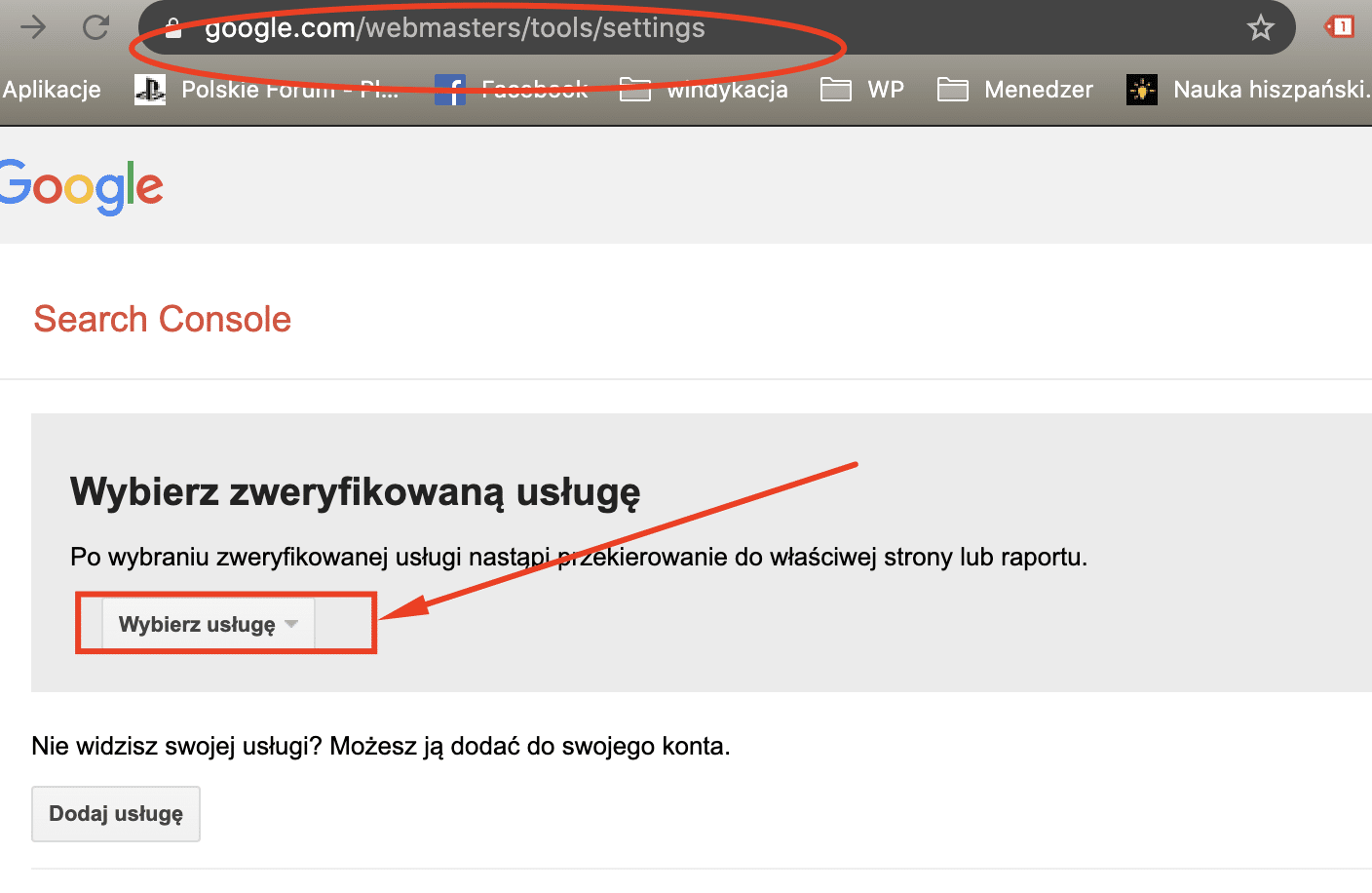

Jest to wskaźnik, który określa maksymalną liczbę danych, jakie mogą zostać pobrane ze strony. Limit współczynnika indeksacji narzuca botom górną granicę żądań, jakie mogą wysyłać w ciągu sekundy. Dzięki temu można ograniczyć ich działalność w taki sposób, by nie spowalniała ona nadmiernie ładowania się strony. Szybkość indeksowania można skutecznie ograniczyć poprzez zmianę ustawień w panelu zarządzania Google Search Console jednak nawet przy problemach przepustowości i wydajności nie jest to zalecana praktyka, gdyż w ostatecznym rozrachunku może przynieść o wiele więcej szkód niż pożytku.

Istnieją inne, sprawdzone metody, z których warto korzystać, mając na celu optymalizację crawlingu w taki sposób, by procesy przeprowadzane przez roboty Google nie implikowały negatywnych skutków w postaci nadmiernego przeciążenia witryny i spowolnienia czasu, w jakim będzie się ładowała.

Chcąc osiągnąć lepsze rezultaty, możesz zdecydować się na:

- optymalizację strony internetowej,

- optymalizację serwerów, z których korzystasz przy obsłudze serwisów internetowych.

Działania w tym kierunku skutkować będą znacznie lepszymi rezultatami.

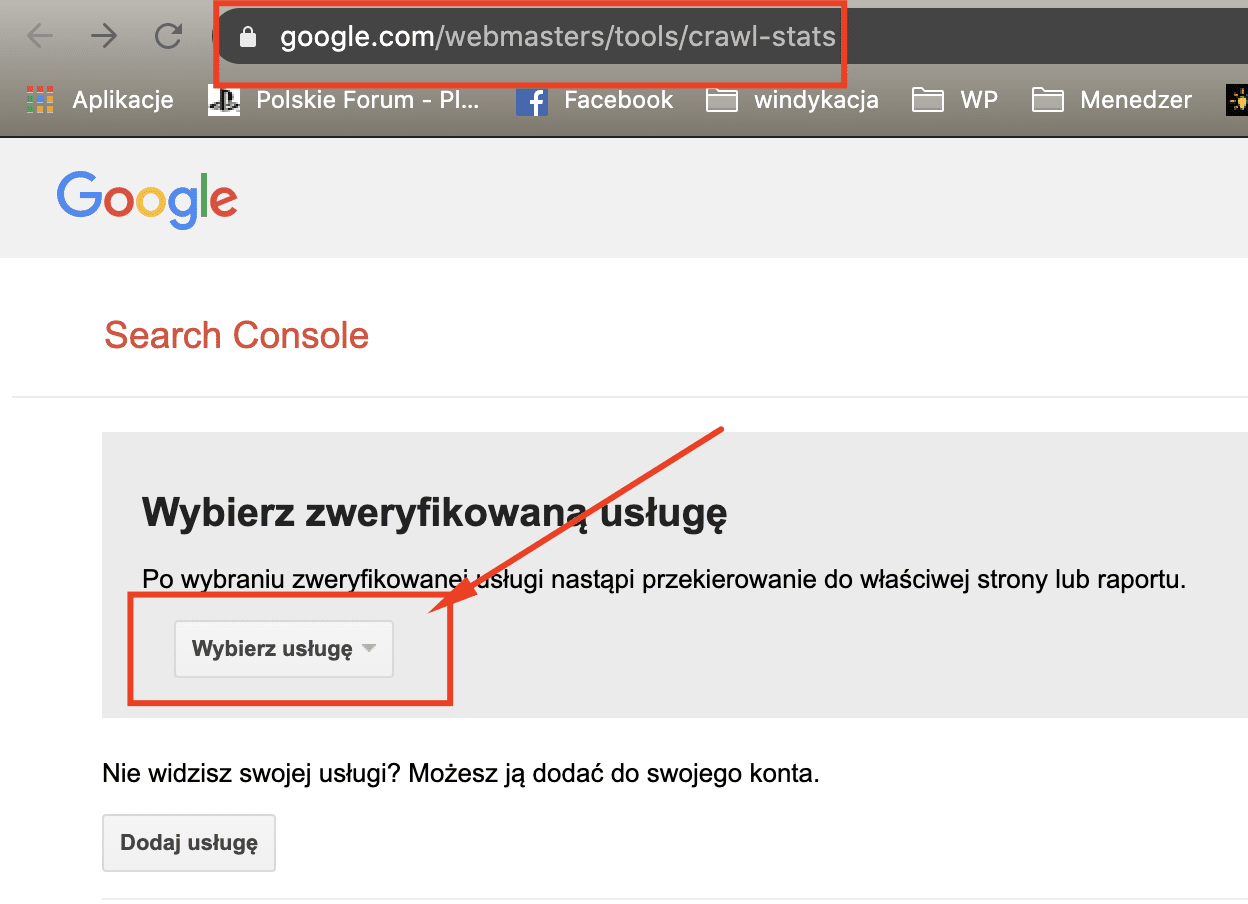

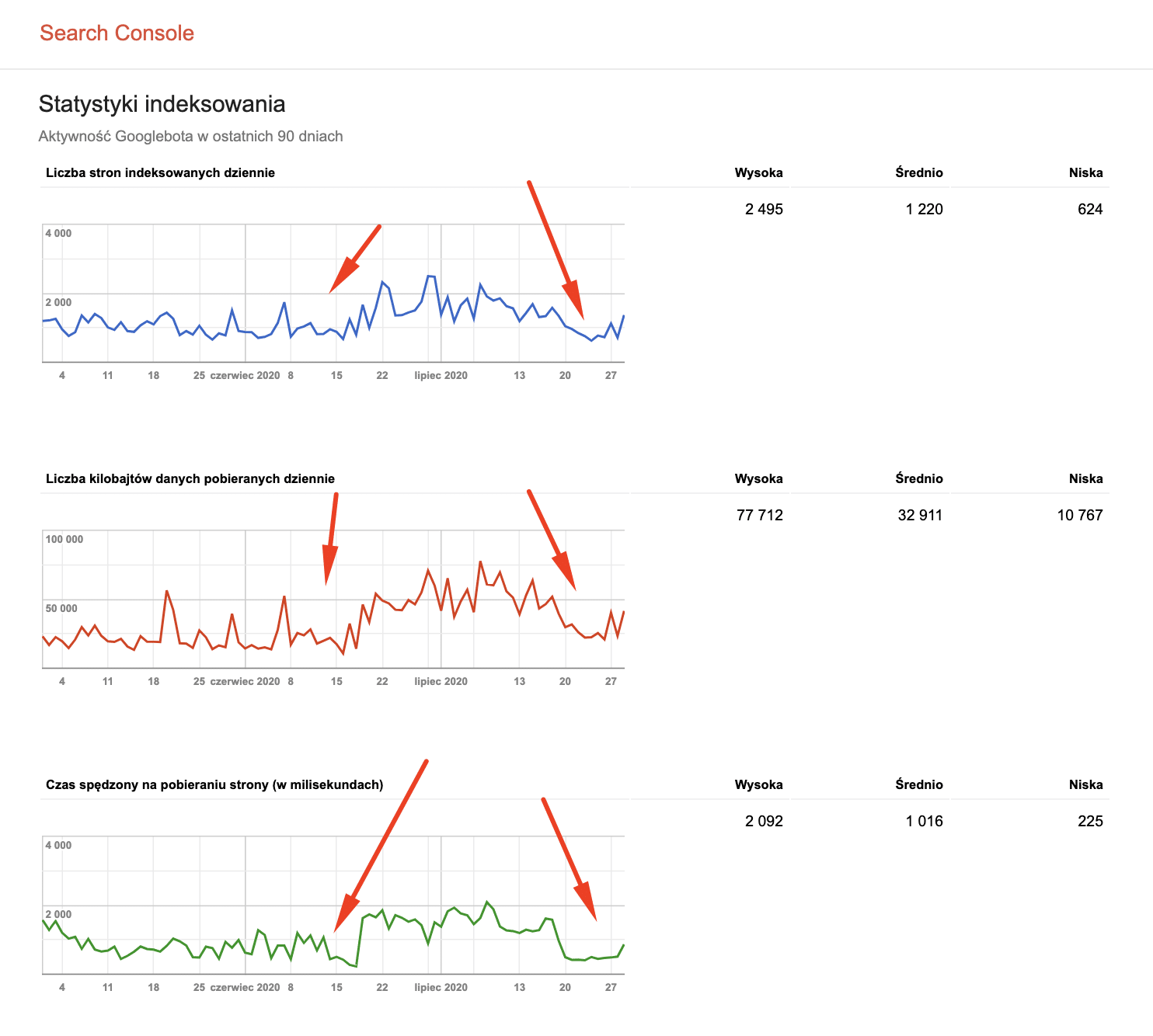

Crawl health

Wskaźnik crawl health określa kondycję crawla. O tym, czy jest w dobrym stanie, czy trzeba pomyśleć o optymalizacji zdecydować może szybkość, z jaką renderuje się strona i udzielane są botom odpowiedzi na zapytania. Warto prześwietlić kwestię prędkości ładowania się strony internetowa. Czynnik ten ma ogromne znaczenie rankingowe – jeżeli Google uzna, że strona ładuje się dużo wolniej niż przyjęte standardy, to wówczas może dojść do wniosku, że nie warto zachęcać użytkowników do jej odwiedzania poprzez umieszczanie jej na wysokich pozycjach w rankingu. Od szybkości ładowania się kolejnych podstron uzależnione jest też zadowolenie użytkownika. Każda sekunda zwłoki to realna szansa na to, że współczynnik odrzuceń wzrośnie jeszcze bardziej. Co zrobić, aby w maksymalny sposób zadbać o zdrowie crawlowania? Optymalizacja serwerów będzie doskonałym rozwiązaniem.

- Wchodzimy tu: https://www.google.com/webmasters/tools/crawl-stats

I patrzymy czy aby nic złego nie dzieje się pod kątem indeksowania serwisu – na czerwono zaznaczyłem swoje podejrzenia (dlatego warto spisywac w kalendarzu coś się zmieniało w serwisie)

Crawl demand

Debatując na temat czynników mających bezpośredni wpływ na jakość crawlowania, należy uwzględnić również crawl demand, czyli popyt. Sama troska o zdrowie nie wystarczy. Trzeba użytkownikom dostarczyć również treści aktualne i świeże, a na tej podstawie Google boty ustawią strony do indeksowania w odpowiedniej hierarchii.

Popularność należy pojmować jako częstotliwość linkowania do strony. Im do konkretnych treści prowadzi więcej zewnętrznych odnośników, tym bardziej w oczach Googla content zyskuje na znaczeniu, co daje mu pierwszeństwo przy indeksacji.

Za świeżość odpowiada z kolei częstotliwość dokonywanych aktualizacji w treści witryny. Im częstsze zmiany i aktualizacje contentu, tym większa szansa, że boty Google skuszą się na indeksację jakiegoś świeżego kęska. Zbyt rzadka aktualizacja treści na stronie będzie skutkować brakiem zainteresowania ze strony robotów – mają one co robić i nie leży w ich interesie to, aby odwiedzać serwisy, w których nic się nie dzieje.

Boty Googla można posądzić o wiele, lecz na pewno nie o przypadkowość działań. Algorytmy są dokładnie skrojone, tak aby wychwytywać najlepsze, unikalne i wartościowe treści, które następnie będą proponowane użytkownikom. To, w jakiej kolejności skanowane będą konkrektne podstrony, w dużej mierze zależy od wymienionych wyżej parametrów. Optymalizując każdy z tych obszarów, można zyskać lepszy budżet indeksowania strony internetowej.

Dlaczego Crawl Budget jest taki ważny?

Rozwój każdej firmy oparty jest na realizacji wyznaczonych wcześniej celów biznesowych. Rozpoczynając działalność w sieci, niemal każda firma stawia pośrednio lub bezpośrednio na dotarcie do nowych klientów. Marketing internetowy daje szerokie spektrum możliwości jeżeli chodzi o poszerzenie bazy kontrahentów.

Warto w tym miejscu wspomnieć o częstym błędzie, który jest udziałem przynajmniej niektórych firm. Ich właściciele wychodzą często z założenia, że wystarczy stworzyć stronę internetową, aby odnieść sukces w biznesie internetowym. Takie podejście do sprawy jest zgoła niewłaściwe. Stworzenie strony internetowej to zaledwie początek długiej i mozolnej drogi na szczyt, którą nieco może przyspieszyć pozycjonowanie strony.

Celem pozycjonowania strony internetowej jest wyniesienie jej do ścisłej czołówki w rankingu bezpłatnych wyników wyszukiwania. Podejmowane w tym celu są rozmaite działania, wpierw optymalizacyjne, a następnie zmierzające ku rozbudowie i dywersyfikacji profilu linków oraz pozyskiwaniu wartościowego contentu. Może się jednak okazać, że całe włożone zaangażowanie nie przyniesie oczekiwanych rezultatów. I w tym momencie dochodzimy do istoty Crawl Budget.

W przypadku, gdy jest on źle dostosowany, boty Google nie będą wykorzystywały całości drzemiącego w nich potencjału przy indeksowaniu witryny. Jest to ogromne marnowanie szansy na pozyskanie nowych użytkowników w serwisie. Wyobraź sobie sytuację, w której dokładasz wszelkich starań, aby zdobyć najświeższe informacje, dostarczyć użytkownikom content najwyższej jakości, po czym okazuje się, że nowe podstrony nie są indeksowane przez długi czas, przez co użytkownicy nie mogą ich odnaleźć w wyszukiwarce. Nie brzmi to nazbyt zachęcająco, prawda? Sprawdź, co możesz zrobić, aby poznać statystyki dotyczące budżetu indeksowania Twojej strony i czy dostępne są możliwości jego optymalizacji.

Poniekąd Crawl Budget jest także częścią analiz występujących w audycie seo.

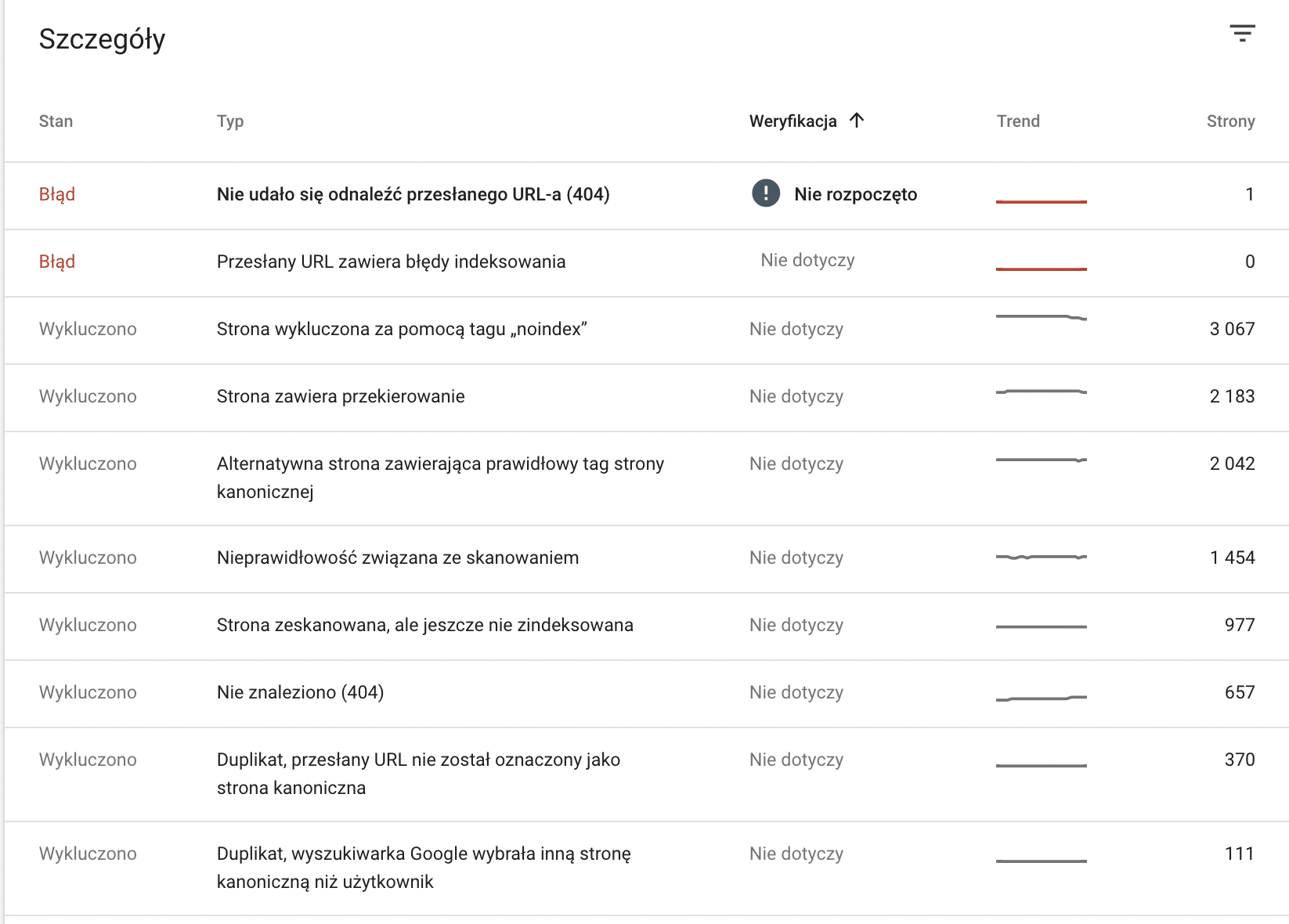

Gdzie znaleźć informacje o crawl budget dla konkretnej strony?

Chcesz sprawdzić, jak przedstawia się Crawl Budget w przypadku Twojej strony? Możesz to zrobić samodzielnie, nie jest do tego potrzebna żadna techniczna wiedza. Wystarczy wykorzystać informacje dostępne w Google Search Console. Jest to narzędzie przydatne pod wieloma względami. W zakładce Indeksowanie, po przejściu do statystyk indeksowania uzyskasz wszelkie niezbędne informacje dotyczące tego, jak boty Google widzą Twoją stronę internetową.

Ważna uwaga – Google Search Console udostępnia wyniki przedstawione na wykresach z konkretnego okresu czasu, a mianowicie z ostatnich trzech miesięcy. Analizując dostępne dane trzeba także wziąć poprawkę na wprowadzane co jakiś czas zmiany w samych algorytmach, przez które w indeksacji stron może nastąpić prawdziwe trzęsienie ziemi.

Od czego zależy budżet indeksowania stron?

To, jak kształtować będzie się crawl budget w przypadku Twojej witryny, zależeć będzie od szeregu różnych czynników. Optymalizacja każdego z nich przyczyni się do osiągania lepszych rezultatów w zakresie skanowania i indeksowania strony przez roboty wyszukiwarki.

Czynniki, które mają istotne znaczenie na budżet indeksowania, to między innymi:

- parametry adresów url,

- zduplikowane treści umieszczone w ramach jednego serwisu,

- błędy 404,

- niewłaściwe przekierowania,

- szybkość, z jaką ładuje się strona,

- plik sitemap.xml.

Warto sprawdzić, czym charakteryzują się poszczególne czynniki i dlaczego każdy z nich ma tak duży wpływ na crawl budget. Optymalizację serwisu warto oczywiście rozpocząć od tego, by sprawdzić, czy roboty mają w ogóle dostęp do zawartości witryny. Jak to zrobić? Wykorzystać w tym celu można plik robots.txt.

1. Parametry adresów url

Każdy z adresów URL to dla robotów skanujących zawartość strony internetowej osobny byt. Jeżeli zdarzają się adresy, które mogą bez potrzeby wykorzystywać crawl budget, a nie są źródłem wartościowego ruchu na stronie, to można rozważyć zablokowanie robotom dostępu do nich przy zastosowaniu odpowiednich atrybutów. Należy także pamiętać o tym, aby przy pomocy Google Search Console ustawić właściwe parametry adresów URL.

2. Zduplikowane treści umieszczone w ramach jednego serwisu

Zduplikowana treść nigdy nie wróży niczego dobrego, a zwłaszcza, gdy umieszczona jest w ramach jednego serwisu. W takiej sytuacji, roboty skanujące zawartość witryny natrafią po kilka razy na identyczny content. Na podstawie zduplikowanej treści sądzą, że informacje zawarte w serwisie nie są wartościowe dla użytkownika, co może odbić się na tym, jaki będzie crawl budget. Z duplikację treści można spotkać się najczęściej w przypadku kategorii produktowych zawierających paginację. Rozwiązaniem problemu może być poprawne stosowanie kanonicznych adresów url, których zadaniem jest wskazanie adresu oryginalnego.

3. Błędy 404

Błąd 404 informuje o tym, że poszukiwana strona nie istnieje. Taka informacja potrafi zniechęcić użytkownika do zapoznania się z pozostałymi podstronami w serwisie. Nie tylko realny użytkownik będzie niepocieszony, gdy jego oczom ukaże się błąd 404. Jest to sytuacja niekorzystna także z punktu widzenia robotów skanujących witryny internetowe i tworzących ranking.

Strony zawierające dużą ilość błędów będą spychane na szary koniec w hierarchii częstotliwości skanowania, a taki stan rzeczy może zakończyć się tym, że istotne z punktu widzenia użytkownika informacje będą czekały w długiej kolejce do zaindeksowania. Straci na tym użytkownik, którego ominie ciekawy news, a także i Ty, bo stracisz możliwość pozyskania dodatkowego ruchu na stronie. Dobra informacja jest taka, że korzystając z opcji oferowanych przez Google Search Console, można bez większego trudu namierzyć wszystkie podstrony zwracające błąd 404 i rozprawić się z nimi raz na zawsze.

4. Niewłaściwe przekierowania

Niewłaściwie ustawione przekierowania mogą stanowić duże wyzwanie dla robotów skanujących zawartość konkretnych podstron w ramach serwisu internetowego. Im dłuższy łańcuch przekierowań, tym sytuacja jest bardziej niekorzystna i może doprowadzić do zapętlenia przekierowań. Warto uświadomić sobie czym właściwie są przekierowania. To one wskazują drogę robotom wyszukiwarki. Dzięki nim boty Googla wiedzą, w którą stronę podążać. Jeżeli zaszwankuje nawigacja, to cała podróż prawdopodobnie skończy się jedną wielką katastrofą.

Na szczęście dostępne są narzędzia SEO, dzięki którym w kilka chwil można sprawdzić poprawność przekierowań istniejących w ramach serwisu internetowego. Chcąc dowiedzieć się, czy wszystko jest w należytym porządku, można skorzystać między innymi z funkcjonalności ScreamingFrog, programu, który przez pasjonatów SEO zwany jest pieszczotliwie Żabką.

Kwestia poprawności przekierowań powinna stać się priorytetem w przypadku migracji treści, na przykład w wyniku zmiany systemu, na jakim oparty jest sklep internetowy. Problem przekierowań może wystąpić także w mniejszych serwisach, choć w nich zdarza się zdecydowanie rzadziej.

5. Szybkość, z jaką ładuje się strona

Zbyt długi czas oczekiwania na odpowiedź serwera może zwiastować nie lada kłopoty związane z indeksacją strony. Brak optymalizacji witryny w tym zakresie, to jeden z najczęściej występujących błędów, niezależnie od wielkości serwisu. Chcąc poprawić wydajność, warto zacząć od tego, aby przy pomocy dedykowanych narzędzi sprawdzić, jak szybko strona ładuje się zarówno na komputerach, jak i na urządzeniach mobilnych.

Poprawa szybkości renderowania będzie przejawem troski zarówno o dobre samopoczucie użytkownika, dla którego każda dodatkowa sekunda oczekiwania na wczytanie się strony to czas totalnie zmarnowany, jak i o odbiór przez roboty wyszukiwarki skanujące zawartość serwisu. W przypadku gdy roboty nie dostaną odpowiedzi od serwera w optymalnym czasie, wówczas mogą obniżyć wartość konkretnej strony, co znajdzie swoje odzwierciedlenie w tym, jak kształtować będzie się crawl budget.

Programy, które można wykorzystać do diagnostyki prędkości ładowania się strony internetowej na komputerach stacjonarnych i urządzeniach mobilnych, to na przykład:

- Web page test,

- Test my site,

- PageSpeedInsights.

Wymienione wyżej narzędzia to propozycje bezpłatne, z których może skorzystać każdy użytkownik Internetu. Przedstawione przez nie dane są czytelne i ich interpretacja nie wymaga posiadania specjalistycznej wiedzy.

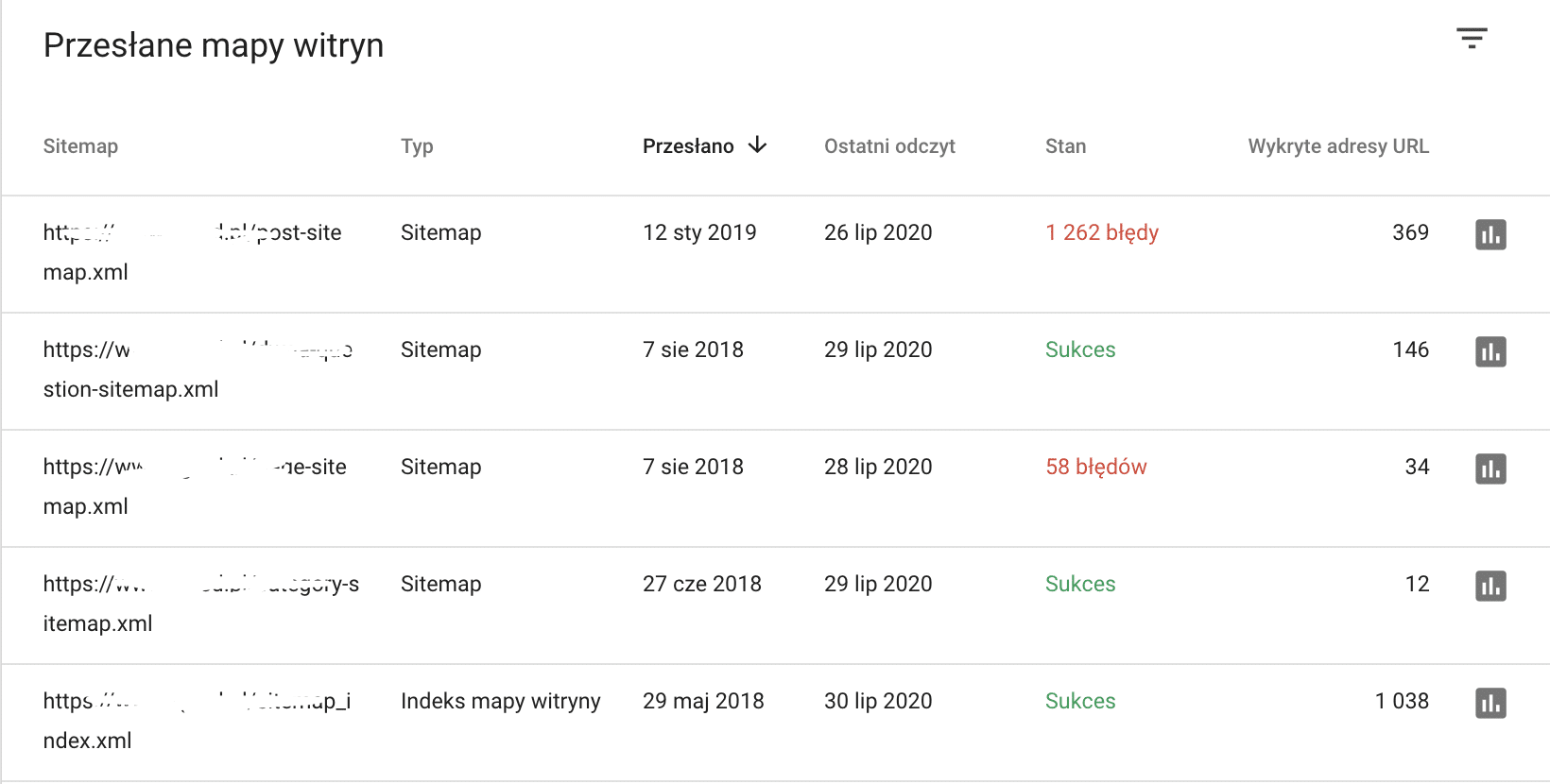

6. Plik sitemap.xml

Mapa strony okazuje się szczególnie pomocna przy bardzo rozbudowanych serwisach zawierających dużą ilość podstron. Administrator witryny powinien zadbać o to, aby w pliku pojawiły się wyłącznie aktualne informacje. Są elementy, które nie powinny znaleźć się w mapie serwisu. Należą do nich między innymi strony o innym kodzie niż 200, strony zablokowane w pliku robot.txt czy obszary wyłączone z indeksowania np. przy pomocy tagów noindex. Jeżeli mapa zostanie zaimplementowana w niewłaściwy sposób, to może to doprowadzić do poważnych problemów z indeksacją strony. Jeżeli chcesz stworzyć poprawny plik z mapą witryny, to oddaj to zadanie w ręce specjalistów. Nie zapomnij czuwać także nad tym, aby na bieżąco aktualizować plik z mapą strony.

Problemy z crawl budget – jak się ich wystrzegać?

Przyglądając się wielu serwisom internetowym, można wskazać szereg najczęściej powtarzających się błędów, które istotnie wpływają na to, jak wygląda crawl budget w przypadku konkretnej witryny. Złe praktyki obejmują między innymi nawigację wewnątrz serwisu zaprojektowaną w nieodpowiedni sposób utrudniającą przemieszczanie się pomiędzy kolejnymi podstronami powiązanymi ze sobą tematycznie czy nadmierną duplikację treści. Zadbanie o właściwą strukturę serwisu może znacząco poprawić budżet indeksowania strony.

Jak zachęcić roboty do częstszych odwiedzin na stronie?

Warto postawić w pierwszej kolejności na oryginalny i wartościowy content i to nie tylko umieszczony na głównej stronie serwisu, lecz także na każdej z podstron. Od jakiegoś czasu można zaobserwować tendencję do tego, że to właśnie jakość prezentowanych treści w witrynie zaczyna odgrywać pierwsze skrzypce przy układaniu rankingu wyszukiwarki przez roboty. Dobra wiadomość jest taka, że treści w serwisie można optymalizować w stosunkowo prosty sposób.

Pamiętaj jednak o tym, że optymalizacja contentu to nie li tylko maksymalne nasączenie go wyrażeniami kluczowymi. Chodzi o zachowaniu równowagi, tak by wilk był syty i owca cała. Równie istotne (a może nawet nieco bardziej) co walory SEO prezentowanych na stronie treści jest zadowolenie użytkownika wynikające z tego, że znalazł on informacje, których poszukiwał. Inwestując w treści wysokiej jakości, sprawisz, że Twój serwis będzie chętniej i częściej odwiedzany przez roboty Google, a nowe treści szybciej zostaną zaindeksowane.

Merytoryczne treści to nie tylko poprawa crawl budget. Miej na uwadze także to, że odpowiednia rozbudowa contentu, ze wskazaniem na frazy z długiego ogona, może przyczynić się do wzrostu konwersji na Twojej stronie internetowej. Wszystko dzięki temu, że strona niejako z automatu, ma szansę znaleźć się na kluczowych pozycjach w bezpłatnych wynikach wyszukiwania na frazy połączone z treścią. Dzięki temu ograniczysz wydatki na marketing oraz zwiększysz swoje zyski. Czyż nie brzmi to całkiem przyjemnie? Poznaj moc contentu i rozwiń dzięki niemu internetowe skrzydła biznesu.

Zwiększ swoją szansę na widoczność w wyszukiwarce

Jak już doskonale wiesz, bez indeksacji, Twoja strona nie będzie się wyświetlać w wynikach wyszukiwania. Ani na pierwszej podstronie organika, ani na żadnej innej. Błędy przy indeksacji witryny mogą mieć różne podłoże, jednak należy je jak najszybciej znaleźć i rozwiązać problem i wówczas – ponownie zgłosić stronę do indeksowania.

Warto pamiętać także o pojęciu Crawl Budget i o tym, że można go skutecznie optymalizować. Oczywiście jest do tego potrzebna odpowiednia wiedza i doświadczenie, jednak poznając ten temat od przysłowiowej podszewki, można sporo zyskać – tyczy się to zarówno niewielkich stron internetowych z niszowych branż, ogólnopolskich serwisów informacyjnych, jak i sklepów internetowych mających w swojej ofercie tysiące produktów.

Korzystając z porad zawartych w powyższym tekście, jesteś w stanie korzystnie wpłynąć na budżet indeksowania Twojej witryny. Im bardziej przyjazna dla Google botów będzie Twoja strona, tym większa szansa na to, że znajdzie się ona na wymarzonych pozycjach w organicznych wynikach wyszukiwania.

Podsumowując: jak dobrze zrobicie techniczne SEO dla swojego serwisu to GoogleBot nie będzie się pocił i bał indeksując Wasz serwis. Dlatego warto z uwagą śledzić wszelkie parametry ale przede wszystkim – zainwestujcie w szybkie serwery.

Temat jak zwykle ładnie opisany, zrozumiale☺