Filtr algorytmiczny w Google to temat rzeka – niestety. Głównym problemem związanym z tego typu karą jest fakt, że jest ciężko postawić prawidłową diagnozę i znaleźć rozwiązanie. Według niektórych źródeł fitlr algorytmiczny to nie jest filtr i nie jest też kara tylko rekalkulacja wyników – ach jakie to piękne stwierdzenie ;).

Wiadomo, że dla filtr w Google typu algorytmicznego nie jest ujawniany w panelu GWT (Google Webmaster Tools) w sekcji „Kara ręczna”. Filtr algorytmiczny to filtr nakładany automatycznie przez wyszukiwarki. Nie otrzymujemy żadnych powiadomień o takich działaniach. Możemy dostrzec jego skutki w statystykach strony i ogólnych odwiedzinach użytkowników. Poszukiwanie jest dość czasochłonne (przez nieustanne testy co jest źle, poprawianie różnych elementów mniej lub bardziej istotnych itede itepe…)

1. Filtr w Google za linkowanie zewnętrzne na frazy exact match anchor (EMA)

Najczęstszą przyczyną filtra w Google jest linkowanie do serwisu – czyli nie jest to jeszcze kara ręczna ale witryna zaczyna się „ślizgać” z ruchem i pozycjami w wyszukiwarce. Mariusz opisał na swojej stronie kilka objawów w tej kwestii: http://techformator.pl/google-jak-rozpoznac-filtr-algorytmiczny-reczny/ – a ja dodam kilka od siebie:

- wszystkie frazy pozycjonowane otrzymuja karę

- witryna otrzymuje „przycinkę”, która objawia się spdakiem ruchu

Zaobserowałem jeszcze taką możliwość, że mamy warianty mieszane czyli:

- częściowy spadek pozycji fraz

- częściowy spadek ruchu organicznego

- lub wszystko razem – spadek częściowy na frazy i ruch

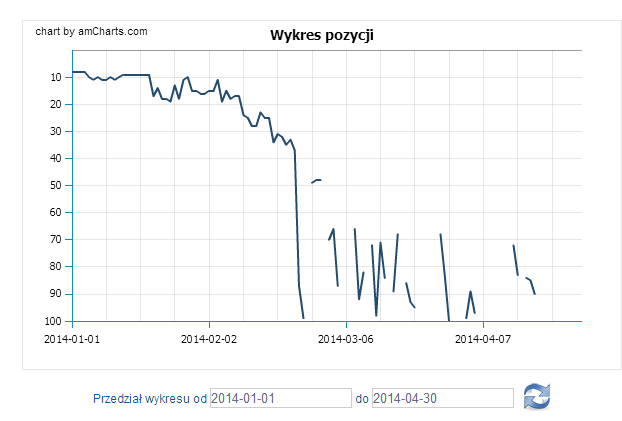

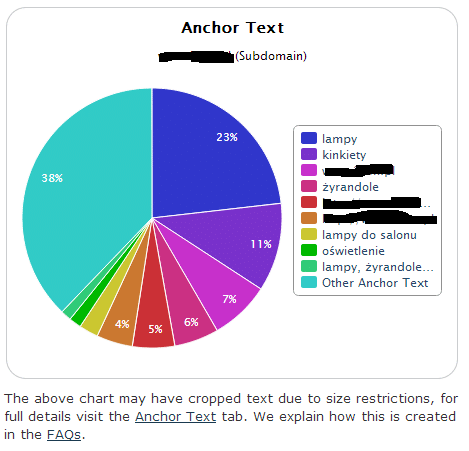

Rysunek poniżej obrazuje frazę „lampy”. Serwis dostał kilka strzałów na kilka fraz (jakies drobne 4 sztuki) – ruch specjalnie nie zmalał. Podziękowania należą się automatom linkujących z różnych for RU na exact match 😉

Dla tego serwisu stwierdzono spadek ruchu rzędu kilku procent, konwersja sprzedażowa też troszkę (ale nie są to pojedyncze procenty).

Obecnie wykonano:

- optymalizację tekstów (w trakcie przygotowania następne)

- rozbudowa starych tekstów/opisów

- dodanie nowych opisów do produktów według analizy BCG (matryca)

- kilka dodatkowych sklepów (satelitarnych)

- disavow dla wykrytych w GWT, MajesticSEO nowych linków -tutaj równiez uwzględniono dane znalezione przez CognitiveSEO

- linkbuilding z tak zwanych „dobrych źródeł” 😉

Oczywistą oczywistością jest, że za linkowanie skupione wokół kilku fraz (słów kluczowych) filtr w Google będzie trzymał dopóki dopóty nie zostanie zmieniony profil linków – IMHO jednocześnie należy edytować stare linki zmieniając frazy na „jakieś inne” oraz zdobywac nowe linki w postaci adresów URL -głównie dzięki użytkownikom (WHS) lub samemu (nonWHS 😉 )

2. Filtr w Google za odnośniki ze słabych jakościowo serwisów

Punkt 1 należy uzupełnić o przypadek kiedy pomimo różnych anchorów praktycznie większość linków (z doświadczenia z reguły ca 90% i więcej) była ze stron o niskiej lub bardzo niskiej jakości (z naciskiem na bardzo bardzo). Wtedy niewiele można zrobić ale trzeba się narobić i to w dośc długim okresie czasu. Zmiana profilu linków zajmie kilka miesięcy. Stąd tez czasem można zaporponowac klientowi zbudowanie drugiego serwisu ale do tego trzeba podejsc rozsądnie – nikt nie zbuduje kopii księgarni z 50 tysiącami pozycji w miesiąc 😉

Zdarzyło mi się dwa razy kiedy tego typu witryny poddały się (wzrost ruchu) gdy:

- pozyskano linki z zaufanych źródeł – czyli zmiana strategii off-site seo

- odcięto SWLe (szczególnie te rotacyjne)

- wykonano disavow (niestety)

- usunięto odnośniki ze słanych witryn (np precle)

Czyli praktycznie postępuje się jak przy filtrze ręcznym ale efekt jest widoczny po kilkunastu tygodniach.

3. Kopie opisów w sklepie przyczyną kary w Google lub wyindeksowania

To jest nagminny problem. Jest to także jeden z podstawowych problemów jakie napotyka się w sklepach typu: odżywki, suplementy, apteki i tak dalej – czyli wszędzie tam, gdzie nie wolno zmieniać opisów z uwagi na prawo (szczególnie widać to właśnie przy aptekach). Wszelkie audyty seo powinny zawierać również wskazanie o tym fakcie oraz sposób przynajmniej częściowego rozwiązania problemu:

- przebudowa kategorii sklepu do takiej postaci aby można było wykonac optmalizację i „wsadzić tam” dobry i rozbudowany opis wraz ze zoptymalizowanymi słowami kluczowymi

- optymalizacja kart produktowych plus jak najsilnieszje linkowanie wewnętrzne

- budowa serwisów satelitarnych z opisem np biegania wyczynowego i jakich odżywek używać – budowa contentu

- moga być tez ordynarne zaplecza „szybkiego sorty i krótkiego żywota” – ale to tylko dla „sezonowców” dobre rozwiazanie

Ostatnimi czasy nagminne staje się kopiowanie opisów ze stron klientów będących w top20 do opisów katalogów, precli, czy tez nawet na strony własnych klientów (kilku ubiłem poprzez DMCA, kilku skasowało opisy wskazane jako kopie).

4. Filtr w Google z powodu błędów skryptu – długi czas odpowiedzi

Rzadko spotykany ale dość łatwy do wychwycenia – błędy skryptu powodujące powstawanie błędów 50x, które odpowiadają za cza s odpowiedzi od serwera. Tutaj różnie mówią ale jeśli czas przekracza 2 sekundy zacząłbym siępoważnie zastanawiać. Mój blog czasami ma „przywieszki” spowodowane dość starym serwerem – zainstalowałem cache – pomogło.

Możliwe jest też złe ustawienie serwera ale to sporadyczne przypadki i z reguły zdarzają się tym dużym 😉 hostingom.

5. „Dziurawy” skrypt – kara czy po prostu ban

Ten element jest trudny do wychwycenia ponieważ jest dużo rzeczy do sprawdzenia. Jednakże nalezy się spodziewać, że w przypadku dziury będizmey mieli ostrzeżenie o szkodliwej witrynie bo istnieje wstrzyknięty trojan, wirus czy iframe… Więc reakcja jest dość prosta.

Warto też sprawdzać wszelki epliki javascript, kóre są popdinane pod np skórki do WordPressów, zakodowane stopki etc…

6. Programy stowarzyszeniowe – partnerskie – najczęstsza przyczyna kary w Google

Filtr algorytmiczny można dostać jeszcze za uczestnictwo w programi partnerskim. W większości jest nakładany filtr ręczny z powiadomieniem o niskiej jakości natomiast nie zawsze. Na forum Google dla Webmasterów zdarzają się pytania i przypadki, kiedy ewidentnie filtr jest za program partnerski a nie ma „ręcznego”. Można to zaoberwować zarówno jako spadek na pozycjach dla pozycjonowanych fraz jaki i w ruchu. Algorytmiczny dotyka całej witryny (z resztą rzadko kiedy jest ona rozbudowana)

7. Upychanie słów kluczowych – kara w Google za keyword stuffing

Filtr można też otrzymać za upychanie słów kluczowych. Jeśli się „przegnie” przychodzi ręczne powiadomienie o naruszeniu wskazówek jakościowych na stronie. Uprzedzam, że nie ma jednoznacznego czynnika ile słów kluczowych może być na stronie i kiedy otrzyma się filtr czy też powiadomienie. Tekst i słowa należy dobierać rozsądnie. Z testów (kiedyś) stron finansowych 120 razy słowo kredyty dało filtra na jednej stronie, ale 50 razy też to samo jeszcze nie. Kwestia zapewne była długości artykułu oraz znacnzików Hx oraz boldowania.

Na koniec drobne podsumowanie o filtrze algorytmicznym:

- związany jest z ruchem i/lub spadkiem fraz

- nie ma komunikatu w panelu GWT

- może istnieć kilka jego przyczyn jednocześnie

- trudny do wychwycenia

- długotrwały ze względu na reakcję algorytmu Google na wprowadzane zmiany

A tak naprawdę nie ma czegoś takiego jak FILTR ALGORYTMICZNY – jest to czysta rekalkulacja wyników.

Przeczytaj także: o aktualizacjach algorytmów Google typu Spam Update.

Uzupełnienie 22-04-2014 🙂

Jak to zwykle bywa coś się przypomni po fakcie. Punkt 6 i 7 dodany.

Najlepiej jest używać monitoringu słów kluczowych (dowolnego) i weryfikować pozycje pojedynczych fraz i ich zachowanie w ciągu kilku ostatnich miesięcy (ale nie dni).

Problemy z pozycjami głównie wynikają z niewłaściwej strategii linkbuildingu.

Tak. Po prostu zmień strategię linkbuildingu i przejrzyj serwis pod kątem optymalizacji danej strony.

Ruch organiczny powinien wrócić na frazy kluczowe, na które serwis spadł w wynikach.

Nie. Przecież wszyscy się pozycjonują więc mogą to być spadki związane z tym, że konkurencja jest wyżej. Aktualizacje algorytmów również nie są przyczyną filtracji.

Jeśli znajdziemy już przyczynę takiego filtru i dotyczą one zawartości serwisu, usuniemy wszystkie problemy, to ile czasu mija, nim filtr zostanie zdjęty? Jest jakaś reguła, czy totalna losowość?

Nie ma reguły – widać to albo po wzrosci epozycji na frazy, albo po wzroście na ruchu, albo obie rzeczy jednocześnie. Czasem mija kilka dni i jest reakcja, czasem kilka tygodni i trzeba szukac dalej bo nie ma reakcji. Problematyczne są linki bo jeśli w nich się grzebie to bez zmiany sposobu i jakości linkowania może być ciężko zrobić cokolwiek 🙁

Dziękuje za odpowiedź 😉

Mam nadzieję, że moje zmiany zadziałają niedługo – od wprowadzenia minęło już prawie 2 tygodnie.

Dodałbym jeszcze, że filtra można dostać, gdy ktoś za spamuje nam serwis (np. komentarzami) linkami do niepewnych stron, a są one dofollow.

Chore jest dla mnie to, że nie ma komunikatu o filtrze. Dlaczego?

A tak to człowiek musi analizowac, szukac itp żeby sprawdzić czy spadek ruchu to skutek filtru…

A po co ma być skoro Google ani nie jest etyczne, ani nie dba o właścicieli witryn. Ta wyleci to będą inne…

Jak strona nie reaguje na optymalizację i dobre linkowanie wzrostem pozycji to po miesiącu starań spokojnie można zakładać, że ma algorytmiczny filtr. Najlepsze rozwiązanie to ciągle poprawianie i rozbudowa on-site SEO, zdobywanie linków z najlepszych źródeł oraz co ważne usuwanie spamu do strony, gdyż w przeciwnym razie zdjęcie filtra może trwać wieczność. Co ważne zdjęcie filtra algorytmicznego jest prostsze jak strona ma go już od roku lub dłużej, wtedy spam do strony „obumarł” na tyle, że filtr może puścić samodzielnie, bez pomocy pozycjonera.

Reklama internetowa dynamicznie rozwija się wraz z rozwojem internetu i coraz większe miliardy firmy tu kierują. Google doskonale to widzi i podejmuje wiele działań aby te środki trafiały do ich kasy a nie do kas innych firm. Mamy więc coraz więcej reklam w różnej postaci pod szyldem Googla. Aby firmy szybciej po nie sięgnęły są zniechęcane do finansowania w działania seo. Jednym z tych działań jest również filtr algorytmiczny a za chwile pojawi się kolejna odmiana pingwina.

Mam jedną tak zafiltrowaną stronę od lat i po walkach o odfiltrowanie stwierdzam, że nie warto się męczyć. Najlepiej postawić stronę pod nową domeną.

No włąsnie jeszcze jednej rzeczy nie opisałem 🙂 Dzięki, że napisałeś komentarz 🙂

I co dalej? Linkować po staremu i za jakiś czas kolejna zmiana? Jak się nie dba o markę i nie zależy na domenie to jest dobre i tanie wyjście.

Znajomy zmieniał domeny 3 razy. Tak działały firmy z portalu aukcyjnego!

Nie bierze się ofert z portalu aukcyjnego. Tanio NIGDY nie znaczy nawet DOSTATECZNIE.

Filtr nawet jak odpuści to strona i tak ma obniżony ranking. Zmiana domeny to najlepsze wyjście.

Wychodzenie z filtrów to dobry zarobek, bo najczęściej zależy na tym mocnym graczom rynku. Wiadomo, że nagminne karanie ma na celu przejście na ppc.

Na chwilę obecna sporo tych zastrzeżeń a pewnie lista będzie się rozwijać w miarę jak pojawią się nowe niechciane przez google „kwiatki” prawda?

Będę się starał rozwijać to na bieżąco 🙂

Posiadam taki filtr od paru miesięcy na jedną frazę jednego dnia jest na 12 miejscu drugiego nie ma jej wcale, profil linków zmieniony, cos można jeszcze robić?

Przede wszystkim nie spamowac mi komentarzy 😉

1. Przestać ją linkować

2. Zoptymalizowac stronę pod tę frazę

3. Możliwe, ze trzeba zmienić sposób zdobywania linków.

Takie gadanie, co to znaczy slaby jakosciowo link ze slabej jakosciowo strony? Mam prosbe wskaz mi o to palcem ktory to jest slaby a ktory jest dobry hehe oprocz strony glownej onetu?:)

Dowolny precel. Resztę sobie dośpiewaj. Lektura poniżej.

http://googlepolska.blogspot.com/2007/08/strony-typu-presell.html

http://googlepolska.blogspot.com/2014/02/nienaturalne-linki-i-wnioski-o-ponowne.html

Czy przy algorytmicznym w przypadku zgłaszania śmieciowych linków należy listę udostępnić pracownikowi G. (w Google docs) czy wystarczy samo przesłanie listy?

W przypadku filtra algorytmicznego nie masz możliwości wysłania żądania ponownego rozpatrzenia. Więc tylko dla Siebie tworzysz taki dokument i wgrywasz go jako DISAVOW – jeśli uważasz, że te linki są śmieciowe i nie możesz ich usunąć.

Największy problem w sklepach to kopiowana treść od hurtownika. A wystarczy ją tylko przeredagować by już mieć lepsze wyniki nawet bez pozycjonowania. I tak jak mówisz oferty z aukcji to niemal pewna kara. Jaka cena takie efekty (przynajmniej te super oferty za 10zł).

Mam stronę od 4 lat i raczej wszystko było stabilnie, powoli się pięła ku górze. Z rok temu jedna fraza którą obserwowałem zaczęła tańce jakieś pozycje 11-4-out-40-7-out i tak z miesiąc trwało w końcu wyleciała >100

A dzisiaj rano na trzech stronach które obserwuję totalna masakra, po ok. 10 fraz na każdej poleciało w dół, a niektóre >100 kilka o 10-30 miejsc.

O ile w przypadku pierwszym mógł by to być filtr, chociaż nie wiem czemu, bo właściwie w ogóle nie walczyłem o tę frazę, to przypadek dzisiejszy to chyba jakieś zawirowania Google, bo filtry jednego dnia na 3 stronach nie związanych ze sobą (budowlanka, zespół muzyczny i motoryzacja) to chyba był by straszny zbieg okoliczności

Odczekałbym kilka dni bo może jakaś rekalkulacja wyników jest. Trzeba też mieć na względzie, że G nie gwarantuje wyników, jak również są inne przyczyny np konkurencja, źle wykonan aoptymalizacja, błędy na stronie i w skrypcie etc… Stąd fluktuacje.

Mam stronę która od jakiegoś ma filtr na daną frazę jednego dnia jest na pierwszej stronie drugiego nie ma jej wcale i tak codziennie linki śmieciowe usunięte. Co robić podlinkować ja czy zostawić na jakiś czas?

Przede wszystkim linkowałbym tematycznie i nie wstawiał (mi tutaj) linka do podstrony 😛 Możliwe, że trzeba sprawdzić optmalizację oraz linki jednocześnie.

dzięki za odp, a jeśli chodzi o optymalizacje podstrony to robimy również nagłówki h1,h2,h3,h4?? i robić to według wskazówek np seoptimer??

O nagłówkah poczytasz tutaj: http://www.bycwidocznym.pl/naglowki-html-h1-h2-h3-podstawy-optymalizacji-strony/

Coś się dzieje w G, o 9:00 część fraz wróciła na swoje miejsce, a nawet awansowały (22–>8, 38–>4), a o 12:00 część znowu poleciała.

Coś się dzieje 🙂 To dobrze :))

Niedobrze, oj niedobrze. Od tygodnia 2 frazy poleciały .>100 niestety. Wcale mi się to nie podoba. Nie wiem czy już zacząć grzebać w linkach w GWT ?

Trzeba.

Witam serdecznie, mam pytanie. Znajomy prowadził sklep na dwóch adresach (oczywiście kopia 1:1 ). Jeden ze sklepów pozycjonowany ten drugi nie. Miesiąc temu wyłączył „duplikat” . Jednak dalej siedzi w indeksie(ponad 5 tys stron.)

Dzisiaj najprawdopodobniej złapał filtr algorytmiczny (brak info o ręcznych działaniach, duże spadki (30+ miejsc w dół).

Czy może to być wynikiem duplikacji serwisów ?

Jeżeli wyłączył kopię miesiąc temu to może coś źle wyłączył ??? Jednakże jesli to aż po miesiącu podjerzewałnym proces pozycjonowania jako niewłaściwie przeprowadzony niż karę za kopię.

Strona odziedziczona pół roku temu po „dużej” firmie z Krakowa. W spadku zostawili spam w seokatalogach. Od pół roku wysyłaliśmy prośby u usuwanie wpisów i strona była dodawana do katalogów typu onet, wp, interia (z listy VIP). Pozycje szły w górę, linkowana praktycznie na frazy brandowe.

Serwis ma problem z linkami wewnętrznymi. Skrypt generuje kilkaset linków ze strony głównej, z czego spora część jest na taki sam anchor(np. 70x baterie) i ten link prowadzi do wygenerowanych na podstawie menu nagłówków h1- też zduplikowanych. Doprowadza to również, do przesycenia tym słowem kluczowym na każdej podstronie (7-8%).

Jeśli wina nie leży po stronie zduplikowanych serwisów, to zostaje kwestia kiepskiej optymalizacji, pozostałości po starej firmie SEO sprzed pół roku lub niedawne dodanie do katalogu gooru.pl (lub wszystko naraz)

Jesli jest jak piszesz to usiadłbym do optymalizacji bezwzględnie. Potem i tak poczyscił troszkeprofil linków (jeśli seoki to napewno jes to grupa lub własciciel esą do namierzenia – problemem mogą być tylko seoki wielokrotnie przenoszone co własnie przerabiam).

Jak chcesz mogę rzucić oczkiem 😉

Dziękuję, poszła PW na info@zgred.pl

IAi – nie mam pytań 😀 Ogólnie optymalizacja na pewno oraz trochę rzeczy przy linkowaniu. Z uwagi że to IAi optymalizacja może być awykonalna.

Powinien ją wyindeksować w GWT, bo jeżeli siedzi dalej w indeksie to G.może ją nadal jakby widzi, pomimo, że jest „wyłączona”

Dziękuję za dużą porcję praktycznej wiedzy odnośnie zdejmowania filtra z witryny – niestety właśnie to przerabiam i sprawdzę w praktyce powyższe zalecenia. Zastanawiam się czy czekać na informację z Narzędzi Google o zdjęciu filtra czy działać już w temacie pozyskiwania „wartościowych” odnośników – nie zmarnuje się taka praca? Dużo linków poleciało w związku z czyszczeniem profilu BL ;S

Z tego co ostatni się dowiedziałem, podobne objawy jak filtr algorytmiczny, czyli znaczny spadek pozycji, może wystąpić również przy niestabilnym serwerze na którym mamy stronę.

Zgłosił się do mnie klient, do strony prowadzi ok 8-9k linków i prawdopodobnie dostała filtr algorytmiczny. Po przepuszczeniu przez odkurzacz połowa odpadła (domeny z banem, errory stron, brak linka), łącznie zostało 3500 linków. Po dalszej weryfikacji wyszło, że ok 100 można warunkowo przepuścić (linki z profili na forach, niestety nawet nie powiązanych z tematyką strony), reszta to meeega słabe precelki itp. Najsłabsze rejony internetu z najsłabszych. I zastanawiam się, czy warto bawić się w wyciąganie strony z filtra (tak przypuszczam, bo stronka poleciała w dół dość mocno) czy zasugerować przeniesienie na nową domenę? Swoją drogą dla klienta byłaby to już kolejna przeprowadzka, po firma po której stronę przejąłem już przenosiła z powodu filtra…. i sama ją do niego wprowadziła 🙂 Do strony nie prowadzą tak naprawdę żadne sensowne linki…. Usunięcie linków nie powinno być problemem – zakładam, że większość to zaplecze poprzedniej firmy. Tylko czy stronka wróci do normy, jeżeli na start dostanie:

– oczyszczenie ze słabych linków

– konkretną optymalizację

– linkowanie na najmocniejsze katalogi

– trochę szeptanki na forach tematycznych?

To działania na start, ale pewien budżet pochłoną i nie wiem, czy nie będą to pieniądze wywalone w błoto….

Wróci … ale naj..sz się sporo i czasu stracisz. Sądzę, że efekty będzie można zoabczyć po kilku miesiącach do roku czasu. Wcześniej się nie uda bo raz że zrobisz to delikatnie a dwa skoro delikatnie to szybko nie nalezy 🙂

Czyli co, bawić się, a ruch na stronie uzupełnić AdWordsem oraz wspomnianymi wcześniej linkowaniami i cierpliwie czekać, czy przenieść wszystko na nową domenę, która od początku będzie miała WHS robione. Bo naprawdę mam dylemat. Jedyną zaleta w tym linkowaniu jest to, że było ono robione na polskich stronach, prawdopodobnie w zapleczu, więc ok. połowę da się spokojnie usunąć i to dość szybko (przynajmniej taką mam nadzieję)

NO ja nad swoim blogiem pracowąłem 1,5 roku zanim wylazł na powierzchnię aczkolwiek na frazę pozycjonowanie jakoś go nie ma 😉 A wiele linków nadal wisi …

Pocieszające .. 1,5 roku. Gdzie można sprawdzić jakość linków, nie rujnując się?

PS. (Strona już bez muzyki.)

NIe ma czegoś takiego jak „jakość linków” – po prostu nie ma.

Jak zawsze dobry artykuł i bardzo cenne i trafne uwagi w komentarzach. Oby tak dalej – czyli nie obniżać lotów 😉

Filtr ręczny i prośba o ponowne rozpatrzenie to wielka ściema pracowników nieomylnego G.

Uzasadnienie proste:

Test 50 domen w ręcznym:

25 ? DNS przekierowany na rejestratora domeny

10 ? DNS przekierowany na domenę w filtrze ręcznym!

10 – bez zmian / dodatkowo disavow link

5 ? nie aktywnych – no live

Teraz tak ? zero tłumaczenia i próśb o wyjście – tekst typu „poprawiono”

W ciągu 7 dni rozpatrzono 34 domen.

W tym 31 pozytywnie, 2 negatywnie, 1 negatywna ale z uzasadnieniem.

I tu nasuwają się proste wnioski jak rozpatrywana jest domena.

Gdzie algorytm a gdzie faktycznie human

Domeny zawieszone powyżej 2m „wyszły” pierwsze

To teraz zrób taki test na serwisach klientów – zrobisz ?

Na bank właśnie mam taki filtr ale chyba tylko na kilka fraz . webmaster tools pokazuje mi w analityce wyszukiwania dla strony frazę gogolin i miejsce 7,9 a w wynikach nie ma nawet w pierwszej setce . Inne frazy pasują miejsca do wyników.

Artykuł świetny nawet po latach wciąż aktualny. Ja mam taki przypadek, że strona nie może wbić się nawet do top 100 na jedną frazę. Pod frazę z filtrem zoptymalizowana jest jedna podstrona. Wszystkie inne frazy pięknie siedzą w top 10. Frazy poboczne od frazy z filtrem też w top 10… A ta jedna wywalona w kosmos. Czy stworzenie nowej podstrony i pozycjonowanie jej wraz z usunięciem starej podstrony coś da?

Sprawdź. Powinno pomóc 🙂

Dziękuję, za szybką odpowiedź. Pochwalę się wynikami za jakiś czas dla potomnych 🙂 Miałbym jeszcze jedno pytanie: czy warto ze starej podstrony zrobić przekierowanie 301 na nową podstronę?

Jak rozpoznać, że strona ma filtra np. tnijurl.com/5ff20d93ecd5 ma linkowanie skupione wokół kilku fraz kluczowych, ale jak sprawdzić czy np. na frazę często będąca w linkach „architekt wnętrz gdańsk” może mieć filtr skoro podstrony wyświetlają się na tą frazę, a na frazę wykończenie mieszkania gdańsk jest w top 30, ale na tą frazę akurat nie ma linków. Spadków widoczności też nie widać. Czy możliwe jest że strona ma filtry tylko na frazy na które jest linkowana?

Nie nazwałbym tego filtrem a rekalkulacją wyników. Może się tak zdarzyć, że na 1-2-3 frazy serwis nie będzie widoczny bo … i tutaj trzeba przeanalizować czy problemem jest np linkowanie wewnętrzne (jego brak), słabe nasycenie słowami kluczowymi na stronie docelowej (onsite) czy nieprawidłowo wykonane linkowanie zewnętrzne.

Czy w tym przypadku powodem może być słaba optymalizacja m.in. upychanie fraz w tytule itp. bo strona główna jest mocna – ponad 100 RD ma? Gdyby była dobrze zoptymalizowana na architekt wnętrz gdańsk to zjadłaby podstronę /aran379acja.html?

Trudno mi odpowiedzieć bo to trzeba zrobić analizę pod rożnymi kątami. Po prostu sprawdź różne elementy.

Jak byś ocenił moc tej strony głównej. Niektóre parametry np. wg. MOZ page authority ma 38 a wg. innych jest nisko oceniona np. wg. DS ubersuggest wynosi 1.

A co mówi Google? Dla Mnie te paramerty są bezwartościowe. Czasem można coś na ich podstawie wyczytać ale należy pamiętać, że są to parametry nieguglowske i przynależą do danej firmy. Wiele tych parametrów da się zmanipulować.

Co mówi google? Nie wiem. Strona słabo zoptymalizowana, na niskich pozycjach itp.

To jak w taki razie odczytać „siłę” strony. Tylko po linkach np. ta strona ma ponad 100 RD, linki niesłabe i teoretycznie (bo bez optymalizacji ciężko stwierdzić) powinna być mocna?

Ale czym Ty się przejmujesz? Jakimiś siłami, współczynnikami? Zacznij tworzyć treści dla ludzi, linkować wewnętrznie, pozyskiwać linki zewnętrzne. Zadajesz mnóstwo pytań – ale co robisz, żeby pójść dalej? Przestań myślec o Google a zacznij o użytkownikach. Poza tym pytania bez podania domeny to dla Mnie jest trudno coś odpowiedzieć.

Ale ja z ciekawości się pytam. To nie moja domena. Czasami natrafiam na takie, sprawdzam z ciekawości parametry i się zastanawiam skąd takie rozbieżności (uczę się), któremu parametrowi bardziej ufać, że strona ma tyle linków i wg. Moz page authority 38/100 a według innych parametrów jest jeszcze gorsza. Kiedyś było Page Rank i nie było problemu. I teraz pytanie jak Ty byś ocenił offsite np. strony głównej czy np. na usługi budowlane gdańsk przy odp. optymalizacji starczyłoby bo są tam wg. parametrów gorsze domeny, mające mniej RD?

Ale to gdybanie i wróżenie. Analizuje sie konkretny przypadek bo diagnozy mogą być bardzo różne. Odpuść sobie jakiekolwiek wskaźniki. Nie odpowiem na żadne pytanie bez konkretnej domeny. Nie umiem teoretyzować.

Ale dałem przecież linka tnijurl.com/5ff20d93ecd5

Moj system nie lubi tnijurl 😉

Ta domena to flize-gres.pl czy np. na usługi budowlane gdańsk,usługi remontowe gdańsk strona główna dałaby radę wejść do top 10 po odpowiedniej optymalizacji bo według niektórych parametrów jest ona lepsza od paru stron znajdujących się w top 10?

Pozycjonowanie lokalne – potrzebne sa NAPy, porządnie prowadzony blog, usługi opisane z wykorzystaniem miast i dzielnic, dobrze opisane wykonane prace i gdzie były robione. Wjedzie ale nieprędko – Mnie zajmuje około roku wprowadzenie na stałe do mapek. Parametry? Nie wiem o jakich piszesz ale nie patrzę na parametry.

Nie chodziło mi o mapki. Czy po samej optymalizacji wejdzie do top 10 bez dodatkowych działań bo ma przewagę offsite?

To jak oceniasz siłę domeny nie posługując się parametrami, czy patrzysz się na jej wiek, linki – ich ilość, jakość (ile linków ma domena linkująca, ich położenie w strukturze – strona główna, czy podstrona)?

Wiek domeny to jedyny parametr, który sprawdzam. Nie – po samej optymalizacji nie musi wejść do mapek. Zależnie od konkurencji będzie trzeba czekać i robić swoje. Za dużo analizujesz, za mało robisz – takie odnoszę wrażenie po tej dyskusji. Pamiętaj, że im więcej zaczniesz analizować tym więcej czasu stracisz. Zrób test – zobacz czy wjedzie. Jak nie – testujesz następne. Myślę, ze chcesz znaleźć złoty środek na wejście i stąd takie analizy – no to Cię rozczaruję – to tak nie działa. Gdybym ja przy ponad . setce projektów analizował tyle zmiennych to by mnie kostucha skosiła. Robię testy kilku rozwiązań – jak coś wchodzi to przenoszę te strategię na inne serwisy.

Czyli rozumiem, że jak porównujesz się do konkurencji to sprawdzasz m.in. parametr wiek domeny, a co z pozostałymi np. Referring Domains, one też chyba mają duże znaczenie i gdy jest przewaga nad konkurencją tych dwóch to znaczy że domena teoretycznie jest silniejsza?

RD nie jest potrzebne do szczęścia bo nie pokazuje wszystkich danych – wiele serwisów ma mniej RD . a jest wyżej. Kwestia jakości odnośników. W przypadku odnośników analizuje się je po kolei link po linku. Nie patrzę na RD bo to bez sensu.

Jak jakość odnośników sprawdzasz? Czy patrzysz się m.in. na: tematyczność tekstu z linkiem, położenie linka na stronie, ilość innych linków na stronie?

Wzrokowo. Po tylu latach rzut oka wystarcza mi na analizę. Ale m.in. to co napisales omiatam wzrokiem.

Optymalizuję stronę na frazę 4 wyrazową np. naprawa klimatyzacji samochodowej Warszawa. Występuje ona w title i h1 bez odmiany oraz w jednym h2: naprawa klimatyzacji samochodowej – Warszawa

Czy powtarzanie frazy w takiej formie: „naprawa klimatyzacji samochodowej w Warszawie” z odmianami 1-2 razy na każde 1000 znaków może prowadzić do nadmiernej optymalizacji?

Też chciałbym wiedzieć. Przetestuj. Wygląda, że powinno być ok natomiast nie wiem jak weźmie to Google.

Widzę w GSC, że przybyło mi linków ze m.in. z domen typu kwalai.com, felsebiyatdergisi.com. Co to jest za rodzaj spamu? Czy jest on szkodliwy i warto dodać te domeny do DT?

Możesz dodawać ale nic z tym nie zrobisz.

Czy przewaga takich linków może być powodem spadków fraz artykułów na blogu z top 10 o 30% po aktualizacji algorytmu 8 listopada?

Nie sądzę. Google świetnie sobie radzi z takim syfem.

Czy powodem spadku może być słaby wynik w mobilnym PSI ok. 20 (czas do pełnej interaktywności ok. 15s, pierwsze wyrenderowanie treści ok. 5 s) Natomiast wynik na komputerach jest >60?

Nie. Mój blog ma PSI czasem zero i jest dobrze 🙂

Czy powodem spadku może być?

-problem z obrazkami. W google cache ich nie ma. W search console otrzymuję „inny błąd”. W mobile friendly test komunikat strona wczytała się częściowo oraz jest stan inny błąd m.in. przy obrazkach

-wysuwany popoup na komputerach na całą szerokość ekranu odrazu po przejściu z serp, wysoki na ok. 25% ekranu, przykrywający tekst, znajdujący się na dole ekranu.

Popup może ale nie musi. Zadaj pytanie na forum zgred.pl/forum/ i podaj domenę to może będzie coś więcej powiedzieć.

Czy subdomena zaatakowana przez pandę (witryna ma takie same treści co są na innych stronach zewnętrznych) może wpłynąć negatywnie na domenę główną, która jest podlinkowana z poddomeny?

Może. Ale nie powinna – na Zgredzie kiedyś stał katalog stron a blog w poddomenie świetnie rankował.

Przed migracją tytuł strony głównej był taki: słowo1, słowo2, słowo3 | nazwa firmy | miasto

I była ona w top 10 m.in. na frazy: słowo1 miasto,słowo2 miasto, słowo 3 miasto

Pozostałe strony tytuły miały takie:nazwa strony | nazwa firmy | słowo 1 , słowo 2, słowo 3

Po migracji nastąpił spadek wszystkich pozycji.

Zmienione zostały adresy z https://www.nazwafirmy.pl na https://nazwafirmy.pl.

Przekierowania zostały utworzone, ale pomimo tego nastąpił spadek wszystkich pozycji.

Czy mogła na niego wpłynąć zmiana tytułów stron na takie: nazwa strony – słowo1, słowo2, słowo3 | nazwa firmy | miasto (został dodany na koniec tytuł ze strony głównej )?

Teraz jak wpisuje frazę „nazwa firmy miasto” to zamiast strony głównej na pierwszym miejscu pojawiają się inne strony na odległej pozycji (15-20).

Jak wyszukuję nazwę firmy to też to też na odległej pozycji pojawiają się inne strony.

Parę dni temu zostały poprawione tytuły na takie „nazwa strony | nazwa firmy” jednak w Google nic się nie dzieje, a w cache dalej są wersje stron ze starym tytułem.

Dodatkowo wpisując do google site:https://nazwafrmy.pl część wyników została pomiętych (Aby pokazać najbardziej trafne wyniki, pominęliśmy kilka pozycji bardzo podobnych do…)

Czy możliwe że pozycje powrócą? Jeśli tak to ile może to trwać?

Przekierowania 301 zawsze są stratne nie mniej jednak nie powinno dojść do takich spadków. Ale opisujesz tylko jeden z wielu elementów więc nie wiem co jeszcze było zmieniane po drodze. NIe jest to filtr na pewno – obstawiam rekalkulację wyników i coś niewłaściwie wykonanego przy migracji.

Ważne jest to co napisałeś: „Teraz jak wpisuje frazę “nazwa firmy miasto” to zamiast strony głównej na pierwszym miejscu pojawiają się inne strony na odległej pozycji (15-20).” – to oznacza, że albo mialeś kanibalizację i jej nie zauważyłeś, albo po prostu kanibalizacja wyszła po migracji i Google nie może ustabilizować pozycji.

Druga sprawa to: „Aby pokazać najbardziej trafne wyniki, pominęliśmy kilka pozycji bardzo podobnych do…” – to z kolei oznacza, że podstrony są bezwartościowe lub slabo przelinkowane zarówno wewnętrznie jak i zewnętrznie i trafiły do piaskownicy – zostały usunięte przez algorytm

Jeśli coś zmieniasz to Google może zareagować nawet po kilku(nastu) tygodniach – to tak nie działa obecnie, że zmiany masz adhoc. Więc jeśli coś zmieniłeś parę dni temu a Google trzyma stary cache i stary index to znaczy, że jeszcze tego nie przemielił albo masz słabą witrynę ze zbyt dużą liczbą bezwartościowych podstron i nie jest w stanie przeindeksować serwisu.

Opisałeś kilka rzeczy, które mogą mieć całościowo i pojedynczo wpływ na serwis.

Przechwyciłem silną domenę zgodnie tematycznie z zafiltrowaną domeną.Czy jak przekieruje ją na zafiltrowaną to jest szansa, że odfiltruje się (zneutralizuje złe linki)?

Nie.

Strona na początku aktualizacji rdzenia (tej z obecnego miesiąca) wypadła z top 10 (po wpisaniu frazy znajduje się w suplementalu lub na dalekiej pozycji pokazuje się strona główna nie zoptymalizowana na tą frazę). Okazało się, że ponad połowa tekstu na stronie była zduplikowana wewnętrzne z innymi stronami (zlepek tekstów z innych stron). Usunąłem tą zduplikowaną część treści tak aby została sama unikalna (obecnie jest 650 zzs, wcześniej było ok 3000 zzs). Stronę przesłałem do ponownego zaindeksowania w GSC czekam 2 dni i pozycja nie wraca.

Jak sprawdzam ogólnopolsko w ad preview tool to widzę czasami stronę w top 10 (czasami na desktopie, innym razem na tablecie). W cache jest jeszcze treść zduplikowana, ale jak wklejam ją do google to nie pokazuje strony, czyli google chyba zmiany przetworzył, ale po jakim czasie strona powinna wrócić do top 10?

Może wrócić dopiero po kilku tygodniach. Obecnie jest jakiś problem z indeksowaniem treści.

Jeśli strona była w suplementalu to rzeczywiście był problem z treściami. Jednak jej poprawienie nie musi być widoczne przez google od razu. Mam obecnie wiele podstron z indeksem z grudnia 2020 a mamy czerwiec 2021. Trzeba cierpliwie czekać ewentualnie zweryfikować jeszcze linkowanie wewnetrzne oraz zewnętrzne.

A dlaczego po kilku tygodniach, przez te błędy indeksowania? Kiedyś miałem problem z tekstem typu „nadmierna optymalizacja” to wróciło po paru dniach i myślałem, że to też tak szybo wróci.

Napisałem „może wrócić”. Obecnie sa spore problemy z indeksacją, poza tym Google samo ocenia kiedy i co indeksować i nie jest tak, że MUSI bo TY chcesz. Trzeba czekać a nikt nie ma szklanej kuli aby jednoznacznie stwierdzić, że będzie indeksować od razu po poprawkach. Mam przykłady gdzie indeksacja następuje po kilku tygodniach o poprawek. Po prostu obserwuj cache serwisu i datę indeksowania.

Przedwczoraj było już ok, myślałem, że całkowicie wróci, a wczoraj znowu zniknęła z serp. W cache widzę, że jest już niezduplikowana właściwa wersja. Dalej występują jakieś problemy w Google?

Bardzo normalne zachowanie w Google 🙂

Robot zaindeksował tekst (po wklejeniu tekstu widzę stronę w serp), ale na powrót pozycji mogę parę tygodni poczekać (tak samo jak często się czeka na wzrost pozycji po poprawie optymalizacji) bo google nie bierze go na razie pod uwagę?

Jeżeli strona jest bardzo mocna i stara to zmiany są indeksowane dość szybko – w kilka dni. Widzisz je w cache. Ale indeksowanie to nie jest tożsame z rankowaniem – może być kilkudniowa różnica, ale może tez w ogóle nie być reakcji, ale też może spaść dalej. Kwestia treści, linkowania wewnętrznego i zewnętrznego. Kwestia tez za co dokładnie jest kara albo filtr na podstronie. A może po prostu konkurencja ma lepiej zoptymalizowany tekst albo ty po prostu gorzej, albo dużo sztucznej treści albo jest niemerytoryczna. Jest ogromnie duzo zmiennych a Ja Ci nie odpowiem wprost – jeśli zmieniam i cos testuję nawet tutaj na Zgredzie to zmian dokonuje raz na kilka dni/tygodni i patrzę – jesli w ciągu 3-4 tygodni nie ma reakcji to oznacza, że coś jest nie tak i analizuję i robię następne zmiany. Podkreślam – kilka tygodni. Nie dni.

Często po zakupieniu domeny pod jej adresem znajduje się strona od providera typu „domena jest utrzymywana na serwerze xxx” np. zlobekalakoala.pl Czy taki komunikat jest zły w przypadku gdy strona ma być później pozycjonowana?

Nie przeszkadza. Normalny zabieg reklamowy dla hostingu/providera.

Czy podstrona tnijurl.com/deec31c0a44a/ może mieć filtr na frazę „regały magazynowe” (dużo backlinków EM na tą frazę) bo w serp na tą frazę zamiast niej w top 20 jest inna podstrona ( tnijurl.com/8691aa4f562b/ ) niepodlinkowana zewnętrznie i gorzej wewnętrznie, ale ma też krótszy tytuł z frazą w odmianie i oddaleniu od początku tytułu.

Raczej jest to zmiana wyników pod wpływem algorytmu. Ale tam – jest spore nagromadzenie EMA kierujących do tej podstrony i może to być dobry trop. Jednocześnie zalecałbym zweryfikować cz zmiany EMA na brandname lub URL pomogą. Kwestia jeszcze samych „miejscówek”. Ahrefs nie widzi jeszcze zmian na „gorsze”.

A filtr na „regały magazynowe” może dotyczyć tylko 1 podstrony i pozostałe mogą rankować bez problemu na tą frazę?

Czy długość tytułu może być powodem tego, że nie rankują na nią strona główna i ta tnijurl.com/deec31c0a44a/ (obydwie mają frazę na początku, ale długości tytułu powyżej 60 zzs)

Może być taki objaw, ze wypada 1 fraza a pozostałe dobrze rankują. Aczkolwiek ważna jest tez intencja bo co innego może być i oznaczać liczba pojedyncza a co innego liczba mnoga. Raczej nie zmienisz rankowania na tę frazę bo to będzie trudne i karkołomne zadanie.

Chodziło mi o to czy jak jedna podstrona dostanie filtra na frazę (w tym przypadku regały magazynowe) to czy ten filtr dotyczy też innych podstron i można np. porzucić zafiltrowną podstronę i pozycjonować inne?

Jak ma się intencja np. w tym przypadku? Czy chodzi o to, że dla liczby mnogiej mogą lepiej paswać inne podstrony niż kategoria?

Nie testowałem zmiany strony docelowej dla danego adresu URL. Teoretycznie można porzucić i zmienić nawet adres URL nie robiąc przekierowania.

Co do liczby pojedynczej i mnogiej – może tak być ale nie musi. Trzeba wpisać frazę i zobaczyć jak rozkładają się wyniki i jakie są strony docelowe i na tan podstawie zdecydować jak pozycjonujemy daną frazę.

Z powodu błędu WordPressa z podstrony został usunięty tekst seo i tytuł. Sprawdzając wyświetlenia w GSC ok. 10 października podstrona zaczęła je tracić .Tydzień temu błąd został naprawiony, podstrona została przeindeksowana, ale dalej pozycje nie wracają. Ile czasu może potrwać powrót pozycji?

Może to zająć tygodnie. Nie ma złotego środka. Może nowe świeże linki zwrotne pomogą.