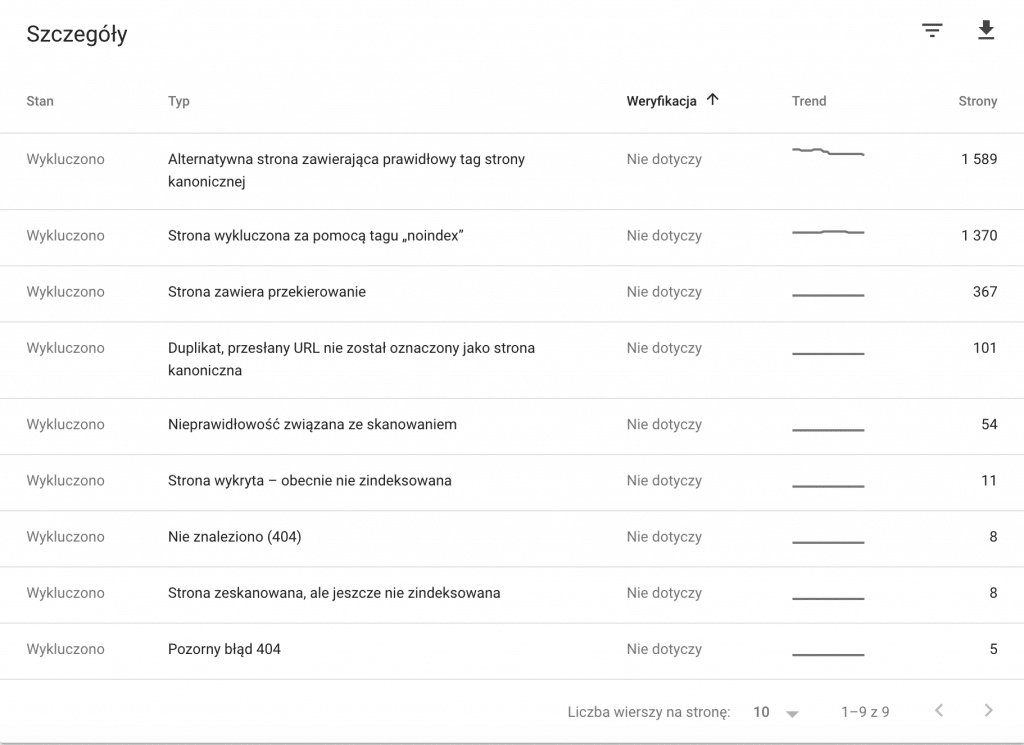

Gdy uruchamiasz swój nowy serwis dbasz, aby każda jego podstrona była zaindeksowana. Do tego celu wykorzystujesz mapy w GSC, mapy HTML, linkowanie wewnętrzne i zewnętrzne oraz szereg innych zabiegów. Dlaczego jednak Google nie indeksuje Twojego serwisu tak jakbyś chciał? Nierzadko dla dużych serwisów nagle Google potrafi wyindeksować dużą liczbę podstron. Na co zatem zwrócić uwagę?

Canonical – niewłaściwa implementacja lub jej brak

Canonical jest jednym z najbardziej krytycznych elementów, które zawsze trzeba sprawdzić (https://support.google.com/webmasters/answer/139066?hl=pl).

- stronicowanie (paginacja) – zmiana sposobu implementacji parametru canonical z typowego „sam na siebie” (czyli indeksujemy całą paginację) na wskazujący pierwszą stronę powoduje, że Google wyindeksuje pozostałe podstrony. Może się też tak zdarzyć, że zacznie wyindeksowywać produkty ponieważ stronicowanie jest jedną ze ścieżek dojścia do produktów dla Googlebota

- brak wdrożenia – jeśli nie masz w serwisie wdrożonego parametru canonical może (ale nie musi) dochodzić do indeksowania podstron z parametrami i bez parametrów. Spowoduje to pojawienie się duplikacji treści a to z kolei zadziała na Googlebota jak płachta na byka – podstrony duplikujące się zaczną być usuwane z indeksu. Dodatkowo w przypadku wersji z różnymi wersjami językowymi canonical jest tak zwanym „must have” – bez niego href lang’i mogą być źle intepretowane

- pusty canonical – jest to niespotykany przypadek, ale może się zdarzyć – wiecie, że taka implementacja canonical=”” (czyli pusto w pazurkach) powoduje, że Google traktuje taki zapis jako „sam na siebie”? No to już wiecie

Zgodnie z Googlowskim manualem podstrony z parametrem canonical wskazujące inna stronę niż własna powinny zostać wyindeksowane. Powinny! Ale nie musi tak być. Przy dużym linkowaniu zewnętrznym strona z canonical’em będzie pojawiać się w indeksie i znikać – jak kierunkowskaz w samochodzie. Ot taka ułomność algorytmów Google.

Blokowanie ważnych plików js,css i grafik

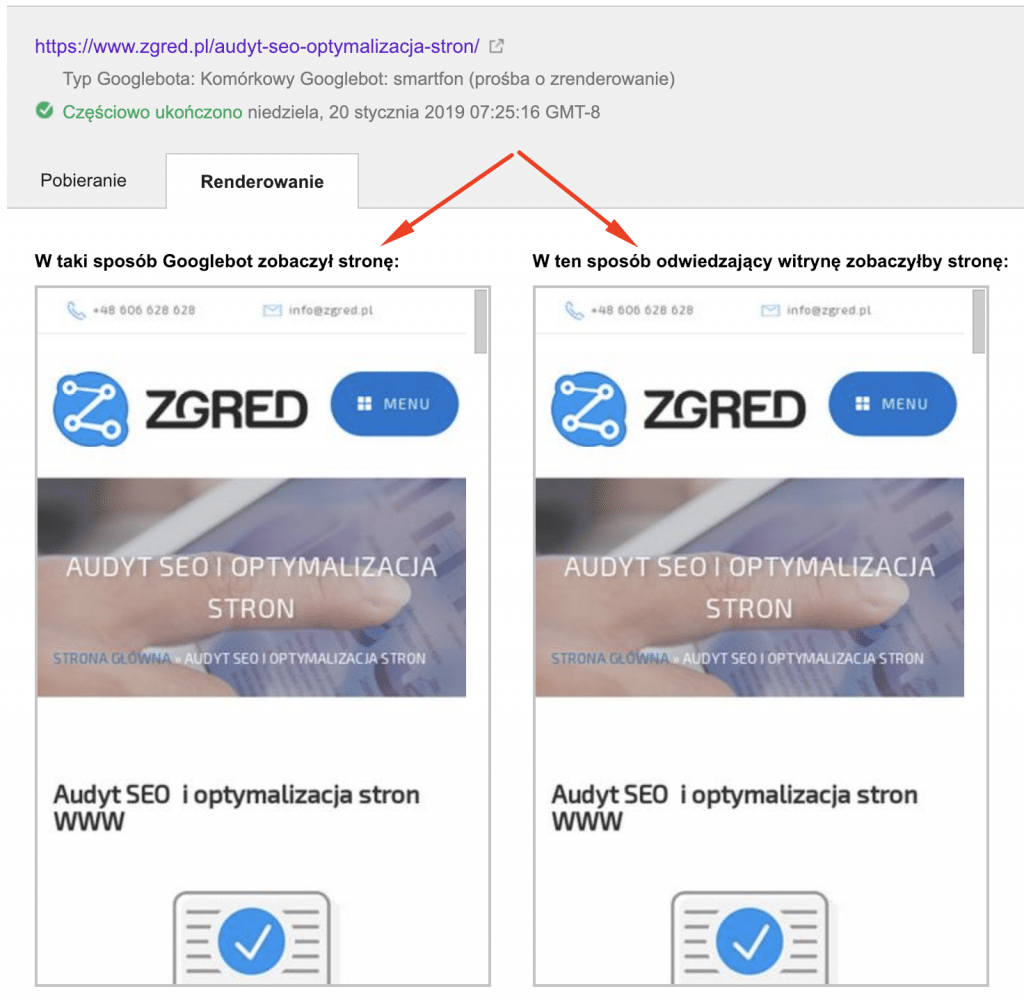

Google zwraca uwagę na sposób indeksowania serwisu pod kątem dostępu do plików javascript, css i grafik. Ich blokada może spowodować wyindeksowywanie serwisu z powodu gorszej użyteczności z jego punktu widzenia.

W narzędziu GSC znajduje się opcja „Pobierz jako Google”, która umożliwia Nam zweryfikowanie jak widzi serwis Google a jak użytkownik.

Oba ekrany, lewy i prawy, muszą być identyczne – jeśli tak nie jest to najprawdopodobniej poniżej tego ekranu, w sekcji zablokowanych rzeczy, widnieje informacja czego Googlebot nie mógł pobrać. Należy zweryfikować to i umożliwić mu pobieranie plików js, css, grafik i innych. Na pewno pojawią się tam skrypty zewnętrzne np. do analityki – tych plików nie uda się pobrać i na takowe nie zwracamy uwagi.

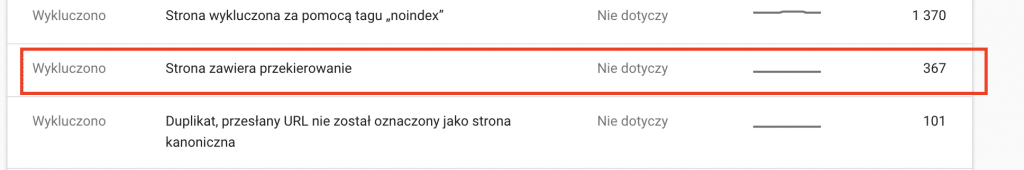

Przekierowania 30x

Zdarza się, że usuwając podstrony w serwisie musimy skorzystać z systemu przekierowań 301. Jeśli robimy to rzadko to Google w miarę szybko, w ciągu kilkunastu dni, potrafi przeindeksować stare i nowe adresy URL.

Należy jednak zwrócić uwagę na to, że częste przekierowywanie adresów URL jednego produktu czy usługi spowoduje fluktuacje w zakresie indeksacji adresów, które modyfikujemy.

W przypadku dużych serwisów przekierować może być bardzo duża liczba i zaczną się problemy, bo w wynikach wyszukania będzie widać stare i nowe adresy URL. Stabilizacja takiego stanu może zając nawet kilka tygodni przez co w GSC mogą pojawiać się różne komunikaty związane z np. adres URL znaleziony przez roboty, ale jeszcze nie zaindeksowany.

W takim przypadku pomocne jest GSC, w którym otrzymujemy komunikat związany z przekierowaniami w serwisie.

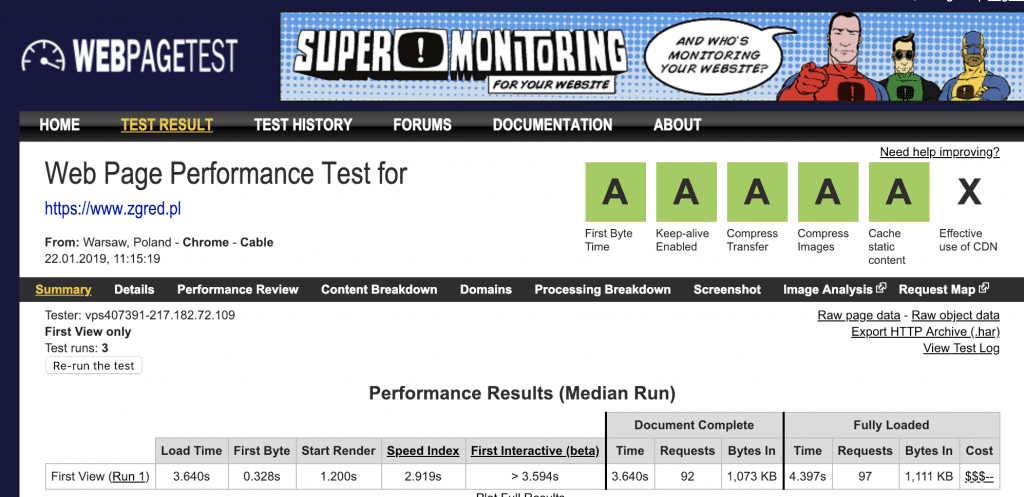

Prędkość działania serwisu

Ważnym aspektem działania serwisu jest jego prędkość działania serwisu. Google coraz większy nacisk kładzie na to aby serwisy ładowały się coraz szybciej. Wpływa to na komfort użytkownika (UX) oraz indeksację plus pozycje w wynikach (SEO).

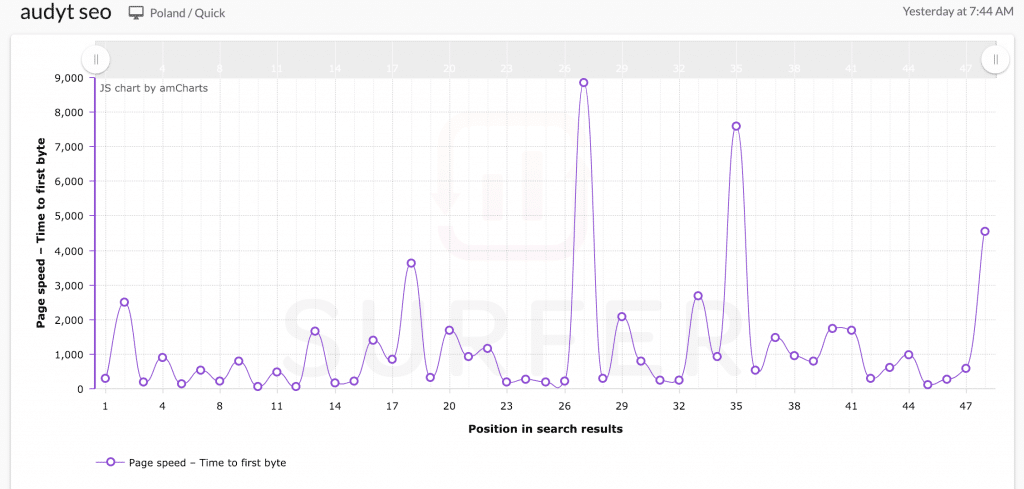

Moim zdaniem, krytycznym elementem na który warto zwrócić uwagę to parametr TTFB – jest to wartość, wyrażona w milisekundach, i która jest mierzona od chwili wysłania zapytania do serwera, aż do chwili otrzymania pierwszego bajtu danych wysłanych przez tenże serwer do użytkownika.

Zazwyczaj weryfikujemy prędkość działania serwisu jedynie dla strony głównej. Jest ona zazwyczaj najcięższa. Warto jednak zweryfikować również prędkości dla kilku podstron. Długi czas ładowania podstron powoduje ich wyindeksowywanie. Nikt nie chce czekać na wyświetlenie strony kilkunastu sekund.

Powyżej wykres TTFB uzyskany dla zapytania „audyt seo” dla wyników organicznych w wyszukiwarce Google – łatwo porównać sobie konkurencję (ja jestem na #19) – wykres z narzędzia SurferSEO.

Treści w serwisie

Jedną z przyczyn słabej lub pogarszającej się indeksacji serwisu może być treść. Kilka przypadków, na które warto zwrócić uwagę to, jeżeli serwis traci na indeksacji to:

- duplikacja treści – jeśli np. partie treści powtarzają się – przykładem jest tabela rozmiarów na każdej podstronie w sklepie internetowym czy też brak unikalnego adresu URL dla usługi czy produktu

- mało treści (thin content) lub jej brak – kilkuwyrazowe opisanie produktu czy usługi, obrazki bez podpisu – to może być przyczyna słabej indeksacji

- upychanie słów kluczowych – w takim przypadku dochodzi do wyindeksowania pojedynczego adresu URL i znalezienie problematycznych podstron może być bardzo trudne (algorytm Phantom) – dlatego tak ważne jest posiadanie dostępu do narzędzia Google Search Console bo tam, porównując konkretne okresy czasu dla poszczególnych adresów URL (a nie słów kluczowych), możemy zweryfikować czy URL jest wysoko na pozycjach czy też został w jakiś sposób ukarany np. wyindeksowaniem

- kanibalizacja słów kluczowych – spotkałem się z opinią, że to też może być przyczyna wyindeksowania serwisu jednak sam tego nie stwierdziłem

- ukrywanie treści – może się zdarzyć, że część treści lub większe partie, są ukryte przed użytkownikiem lub robotami Google – jest to tak zwany cloaking i może to spowodować niewłaściwą indeksację serwisu. Warto też sprawdzić poprawność indeksacji podstron, weryfikując cache w wynikach wyszukania. Może się okazać, że jakieś partie podstrony sa niewidoczne w cache – i bynajmniej nie chodzi o elementy wykonane ajax’em czy javascriptem.

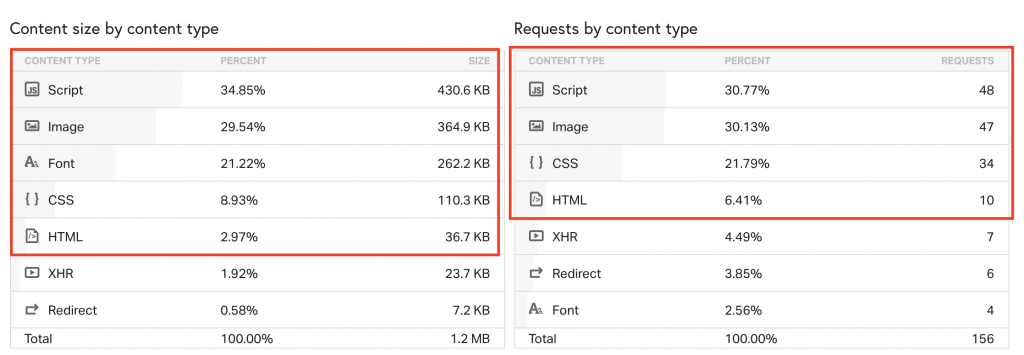

Za dużo zasobów, za mało contentu

Google zwraca uwagę na to ile obrazków, skryptów i danych jest pobieranych w trakcie ładowania strony internetowej. John Mueller mówi:

“The more resources required, the longer time until the critical content is visible, the more likely Google will have trouble indexing the critical content.”

Czyli jeśli treści w stosunku do kodu I skryptów będzie mało oraz liczba niezbędnych do wykonania połączeń będzie bardzo duża, strony będą coraz wolniej ładowane. Wydłużony czas ładowania serwisu może mieć wpływ na indeksację.

Mała podpowiedź – mapa serwisu

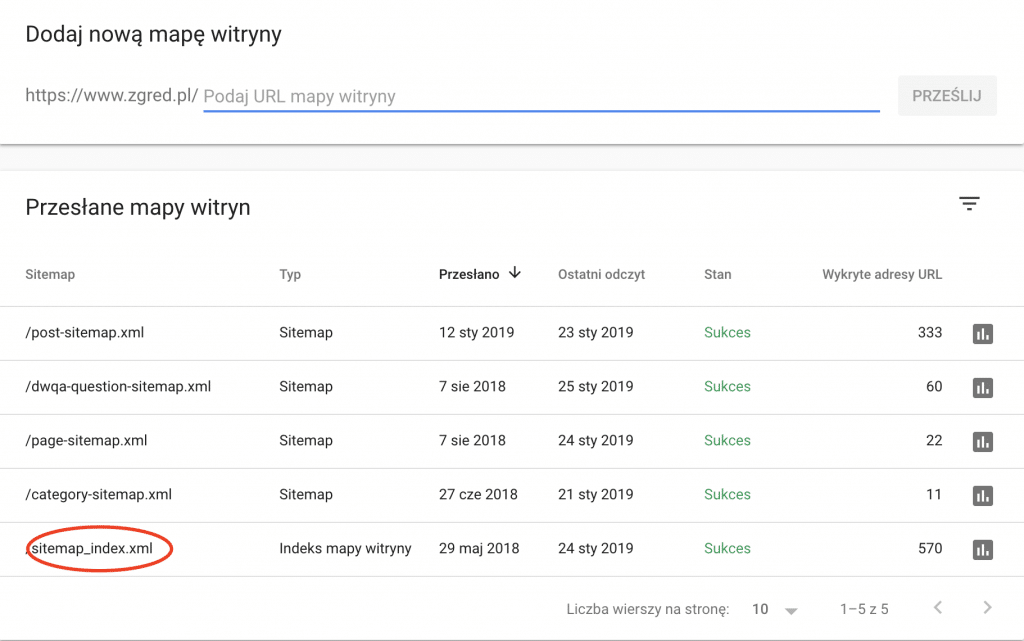

Bardzo często użytkownicy dodają do GSC tylko jedną mapę. Nie ma problemu gdy mapa ta zawiera kilkadziesiąt adresów URL i kontrola poziomu indeksacji jest bardzo łatwa. Jednak pomimo małej istotności tego elementu warto się nad nim pochylić.

Zauważcie, że pomimo małego serwisu, poszczególne typy treści na blogu są rozbite na kilka drobniejszych map. Pozwala mi to zweryfikować poziom indeksacji dla poszczególnych sekcji mojego serwisu: wpisów, forum, usług. Na czerwono zaznaczyłem mapę główną, w której znajdują się odnośniki do innych plików map.

Takich plików mogę dodać 200 (testy pokazują, że nawet więcej), w każdym pliku mogę umieścić mapę map lub do 50 tys adresów URL (plik ma też określona maksymalną wagę).

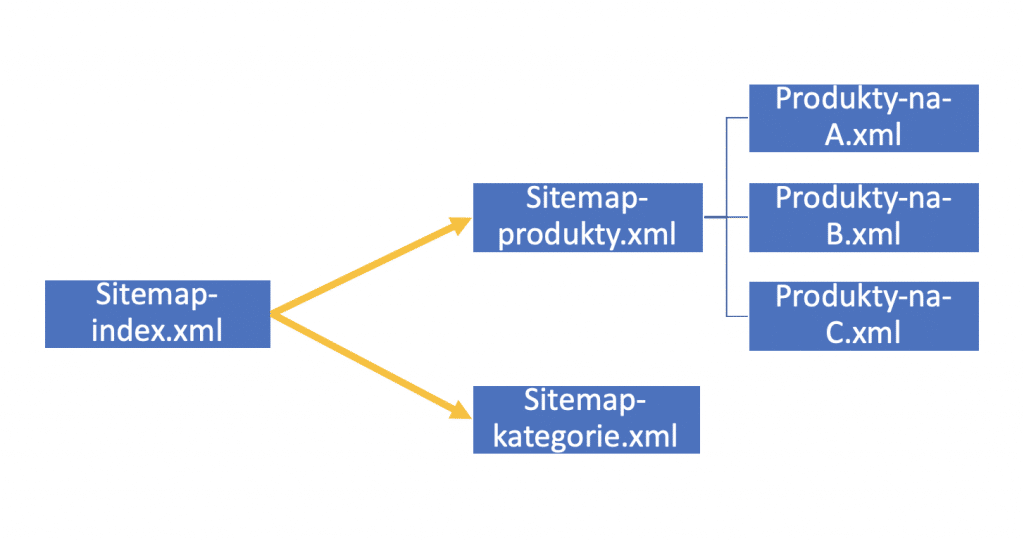

Czyli rozbijając mapę na pliczki mogę wykonać coś takiego:

Rozbicie mapy na drobne pozwala mi weryfikować poziom poszczególnych sekcji sklepu oraz poziom indeksacji produktów. Takie rozbicie ułatwia życie szczególnie przy serwisach z fototapetami, gdzie indeksacja jest niezwykle ważnym elementem pozyskiwania ruchu organicznego.

Podsumowanie

Poza przypadkami wskazanymi powyżej warto też sprawdzić:

- plik robots.txt – czy nie zablokowaliśmy całego lub części serwisu

- meta nagłówek – czy nie wstawiliśmy noindex

- poleceniem site: czy domena nie została usunięta z indeksu

- DMCA – czy ktoś nie zgłosił roszczeń do treści

- Framework – czy serwis w ogóle się indeksuje bo ktoś mógł skopać wdrożenie np. angulara

Oraz inne przyczyny wyżej nieopisane. Przyjemniej lektury 🙂

Bardzo fajny artykuł. Ja dodam jeszcze coś ze swojego doświadczenia – uważajcie na blokadę „fakeowych” Googlebotów za pomocą wtyczki „All In One WP Security & Firewall” do CMS WordPress – można w ten sposób skutecznie zabronić indeksację naszej strony…

Jeżeli mam subdomenę jako landing page to trzeba umieścić canonicala?

Nie trzeba. Pytanie: do czego używasz tej subdomeny?

Jako przekierowanie do domeny(sklep). Subdomena to zwykła stronka na html/cms.

Jesli LP jest tylko pod Adsy i nie musi siedzieć w indeksie to canonical na stronę, którą chcesz wzmocnić. Jeśli to ma siedzieć w indeksie to w stopce wrzucasz link wewnętrzny z anchorem do strony docelowej (lub nawet do kilku stron).

Ostatnio w moim search console w zakładce

Strona wykluczona za pomocą tagu „noindex”

pojawiły się:

https://adresstrony/sitemap_index.xml z 4/01/2019

https://adresstrony/category-sitemap.xml z 31/12/2018

https://adresstrony/page-sitemap.xml z 31/12/2018

https://adresstrony/post-sitemap.xml z 31/12/2018

Czy jest to błąd Yoasta ?

W robots.txt mam typowe parametry, rzecz jasna niewykluczające własnych map xml.

Co powinienem zrobić w takiej sytuacji ?

Prawdpopodobnie w plikach mapy masz adresy URL, które wykluczyłeś z indeksu za pomoą „noindex” – też tak mam 🙂

W ostatnim czasie zauważyłem znaczne spowolnienie w indeksowaniu nowych strony w serwisie. Dodany wpis blogowy nie zindeksował się przez 3 tygodnie. Dopiero wrzucenie adresu do GSC pomogło (po kilku dniach). Zaobserwowaliście podobny trend?

Tak. Google mocno spowolniło indeksację i wymuszanie indeksowania.

Warto sprawdzić jeszcze nagłówki http. Mało popularny X-Robots-Tag może też blokować indeksację stron.

Blokowanie ważnych plików jak CSS, JS itp. jest często spotykane w robots.txt stron Joomla! W standardzie ten CMS ma to źle zrobione. Dużo zasobów trzeba odblokować na samym wstępie.

Nie znam żadnej innej strony, żadnego innego bloga o tematyce SEO, gdzie tak prosto, przejrzyście i wnikliwie przedstawia się zagadnienia SEO.

Od miesiąca mam problem z sitemap-news.xml. W mapie witryny Google News wykryto 16 adresów, a stan w indeksie wynosi tylko 3. Dlaczego google nie indeksuje mi wszystkich adresów?

Niestety nie znam odpowiedzi – nie zajmuje sie Google News’ami. Zapytaj tutaj https://support.google.com/webmasters/community?hl=pl

spróbuj wdrożyć 'instant indexing’

Przekierowałem tydzień temu za pomocą meta refresh jedną z podstron na inną znajdującą się pod drugą domeną (a.pl/podstrona na b.pl/podstrona) Canonical też wskazuje na b.pl/podstrona. Te same treści są na obydwóch podstronach. Jednak w serp jest cały czas jest stara podstronan i link prowadzi też do niej natomiast jak sprawdzam cache to tam jest kopia nowej podstrony pomimo jej niezaindeksowania. W GSC po sprawdzeniu URL wersji opublikowanej widzę że jest zrzut ekranu podstrony „b.pl/podstrona” natomiast przy adres kanoniczny wybrany przez Google jest informacja „Określane tylko po indeksowaniu”.

Wyszukując w cudzysłowiu jakąś treść, która jest tylko na b.pl/podstrona widzę, że również w serp jest z stara podstrona, a w pamięci podręcznej jest kopia nowej podstrony .

Czy to znaczy, że trzeba odczekać aż google zaindeksuje nową podstronę i wtedy serp się zaktualizuje?

Tak, trzeba czekać. Jednocześnie warto usprawnić linkowanie wewnętrzne i zewnętrzne. Tylko czekać można i pare miesięcy. Warto abyś też sie nie denerwował, bo przez wiele miesięcy obie podstrony będą widoczne.

Oj Panowie Seowcy z ?

Wustarczy wejsc na Hinduskie forum hacking i ma sie zindexowane wszystko w ciagu dwóch dni.Nawet nową stronę z 700 podstronami

Hindusi znaleźli hack tani nie jest po 470 Usd/miesięcznie ale działa.

Wy tu pitu pitu

A Panowie z Indii posiedzieli poszukali znalezli dziurę i napisali system

Ech białe Seo wam zaszkodziło.Dobrze że was nie czytam od lat.

Można miec badziewny tekst słabo zoptymalizowane obrazki a wręcz krowy cieżki lay.

BAwcie się dalej w białe seo 🙂

O fajnie że zajrzałeś. Jesteś jak kometa Halleya – zabłyśniesz myślą raz na 76 lat i jest fajnie 😛

Warto przywołać dwie kluczowe wypowiedzi „rzecznika” Google, Muellera – 2015 „we never index all pages” oraz 2021″“There’s nothing really special or new about „discovered / not indexed” — It’s essentially „we saw you, but maybe later, or never”. Does it confuse people too much? Should we remove it?” Rzeczniczka Binga też mówi, że indexowanie kosztuje (energię) i jest ograniczone.

Gdybyśmy się ich słuchali nie byłoby indeksacji w ogóle 😉

Rozpoczął się rok 2023 wpis już troszkę stary ale udało mi się poprawić kilka rzeczy na stronie. Dziękuje pozdrawiam.

Nadal aktualny skoro umieszczasz w komentarzu link do podstrony aby ją szybko zaindeksować 😉